关于ChatGPT的五个最重要问题

孙煜征经受权转载,仅代表做者小我看点

我们揣度,假设ChatGPT不犯大错,两年内,对整个科技行业以至人类社会都可能影响深远。倒计时已经起头了。我排一个两年后ChatGPT能做到的工作以及可能性:

1、专家级 答复事实性的问题(99%);

2、专家级 答复揣度性的问题(80%);

3、每小我的 数字学徒(75%);

4、把 编程提效十倍(70%)-- 小团队半年时间就能开发3A级此外游戏;

5、间接要求 成果(50%);

6、替我打工(50%);

7、写出一篇如许充满原创常识的文章(5%);

那里再打几个例如,那几个例如是尽量准确,而不带误导的:

1、iPhone是人体传感器和功用器官的延伸,ChatGPT是人脑的延伸,只要互联网、阅读器、iPhone等少数创造能和ChatGPT的倾覆性比肩;

2、过往的计算机只能“模仿”,ChatGPT能够“理解”;

3、ChatGPT之于过往机器进修,是后膛枪之于弓箭手,意义不在于两者的性能比照,而在于热刀兵的时代已经开启,而且开展是加速度的;

4、ChatGPT是“天然语言计算机”,是人类挪用数据与算力的近乎完美的形态;

5、ChatGPT会让“智力分发”的边际成本趋近于零,人力本钱的杠杆变得无限大;

6、所有系统与数据库都值得被ChatGPT重做一遍;

展开全文

7、ChatGPT应该存眷理解才能的构建。

但是上述的结论和例如,在看完全文之前,都没什么用,因为我们不晓得是实是假。假设对ChatGPT到底是什么不领会,那就只能比谁说话更语出惊人、更金句,而不是谁揣度更准确、更有洞见。所以我们要花浩荡的功夫,写出那篇文章,让各人晓得我们晓得什么,不晓得什么。

GPT-4在3月15日震动发布了,但是本文看点、推演、结论不需要任何大改,因为对手艺的理解是准确的,对才能范畴的理解与推演也是准确的。其实文章并非对GPT-4和能到达的工作有任何“揣测”,而只是“简单推演”。所以就不从头修改了,比照现实,正好能让各人看清晰什么是天天改变的,什么是稳定的。

哪五个问题?

在ChatGPT纪元中,发问题的才能和揣度力也许是人类最重要的两个才能。我们那里提出五个关键问题,而且试图抛开收集上的二手看点,做出基于原理的揣度。围绕那五个问题,我们会把所需要晓得的相关手艺布景,尽量简洁但是无损地总结清晰,不说废话:

1、是什么:ChatGPT是范式打破,仍是过往AI的延伸?

2、会如何:ChatGPT两年内会到达什么水准?

3、行业格局:ChatGPT以及GPT有壁垒吗?

4、若何参与:我们将来应该若何利用ChatGPT?

5、人文:人类和ChatGPT的素质区别是什么?对人类社会的冲击?

我们搞清晰那五个问题,就能揣度市道上大大都解读ChatGPT的看点,无论从手艺、贸易、投资等等角度,能否靠谱了。其实就两个关键:

1、对ChatGPT新才能的认知:那新才能到底是什么,有多大“纷歧样”?阿谁“纷歧样”能带来几新的可能性?

2、对“才能获取难度”的认知:ChatGPT若何获得的?他人获取类似才能,难度有多大?

文章结尾我们会做一下总结。让你下次见到某大模子,能够揣度那是ChatGPT的80%仍是0%。也能够揣度本身的工做会被ChatGPT代替几。

为什么如许问?

比来四处都在讨论ChatGPT,但是关于ChatGPT如许一小我类高科技结晶的新物种,不先搞清晰它“是什么”和“为什么凶猛”,那就没有办法构成本身的揣度。没有本身基于原理的揣度,看ChatGPT就像看元宇宙、Web3、主动驾驶一样,觉得似乎很凶猛,也有一套看似自洽的逻辑,以及振聋发聩的“洞见”,其实只能被他人牵着走。

搞清晰ChatGPT“是什么”和“为什么凶猛”是一件困难的工作,因为最顶尖的人工智能大佬们也没有达成共识。好比Meta的AI负责人,深度进修三大佬之一的LeCun就不看好,认为那就是个基于auto-regressive(自回回)的LLM(large language model,大语言模子),从办法上来讲没有啥范式打破。只是因为OpenAI是个创业公司,各人宽大度比力高,ChatGPT在乱说话,各人也能容忍。

另一面,ChatGPT的炽热就不说了,好比特斯拉的首席AI科学家就抉择回到OpenAI,共建AGI(artificial general intelligence,通用人工智能,也是OpenAI的逃求目标);Meta的VR开创人卡马克抉择分开Meta,本身开一家AGI公司。别的一篇文章[1]截取了大佬们的赞誉神异的点就在于,两边也许都是对的。ChatGPT确实不是一个“新的模子”,而是即有模子的开展与组合;但ChatGPT又足够纷歧样,让包罗我在内的良多AI相关的从业者,有第一次见到光的觉得。我们在第一章会花大篇幅往讲一下为什么ChatGPT的原理是填词,但它的新才能却远远不是“填词”罢了。

手艺插播:“自回回”“大语言模子”是两个关键词

1、自回回的意思是,我先用模子揣测下一个词是什么,然后把揣测出来的词带进模子,往揣测再下一个词是什么,不竭迭代。那是过往语言模子的通用范式,也能让各类语言类使命同一成“生成式”使命。

2、大语言模子的大是指海量参数,从而能吸收海量数据中的信息。那是在transformer模子之后成为可能的。大语言模子自己也值得手艺科普一下,我们在第一个问题中展开。

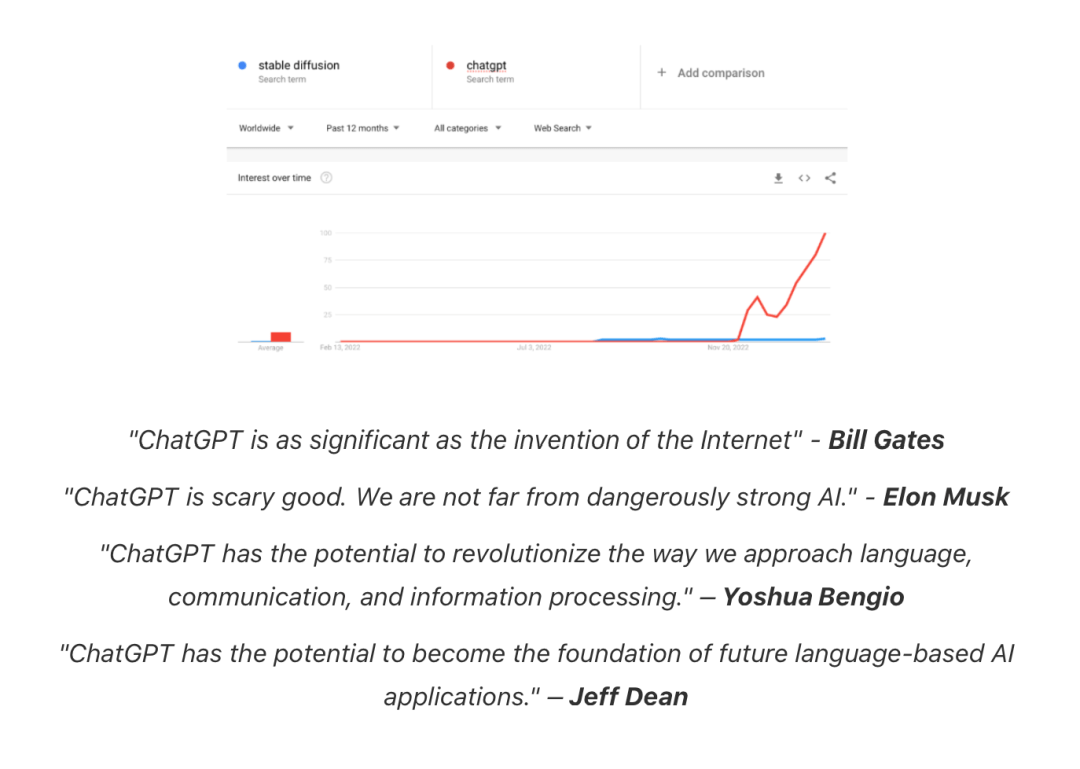

ChatGPT的最根本版汗青

起头问问题之前,有一些需要的手艺科普。我们着重参考两篇综述,尽量挠重点:

1、大语言模子手艺精要[2]

2、ChatGPT的各项超才能从哪里来[3]

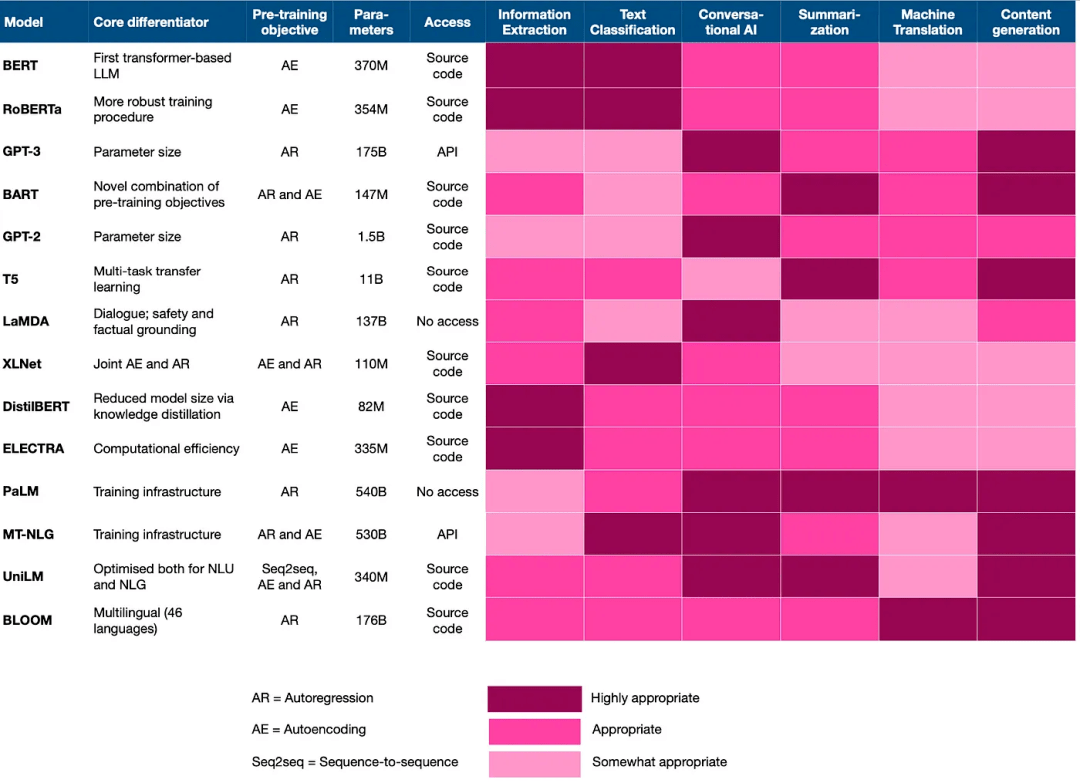

第一份综述次要讲了大语言模子开展中的关键手艺打破,第二份综述次要讲了ChatGPT开展过程中的几个重要模子“做到了什么”和“有什么不同凡响的做法”。我们把两篇文章的重点挑出来,标注一下里程碑事务和其意义。

事务

意义

Transformer问世让深度进修模子能够“自在吸收”数据中的常识

大语言模子打破了参数和算力限造,从此语言模子也进进参数越多,数据越大,模子效果越好的时代。

LLM内战,逐步吊打老NLPGoogle的Bert道路和OpenAI的GPT道路各有所长

GPT通过“天然语言生成使命”,兼容了几乎所有NLP问题;但是Bert比GPT2表示好。此时大语言模子已经起头吊打传统NLP模子了

GPT3问世展现in-context learning才能,简单调教下就能吊打精调过的良多模子

一方面让GPT形式初现一统江湖的潜量,一方面GPT3的 in-context learning才能,展现了和过往ML的fine-tuning形式的素质区别,我们鄙人面零丁详尽展开

- InstructGPTChatGPT的交互形式,让GPT的才能,愈加切近人类实在交互体例

在in-context learning根底之上,进一步降低了prompting的门槛;必然水平处理了GPT-3生成成果与用户期看纷歧致的非预期输出,大幅降低了有害的、错误或误差的输出成果,让GPT更契合人类胃口

- GPT读代码代码操练才能的提拔是GPT3到GPT3.5的重要迭代之一,模子从而能够生成代码和“理解”代码

Codex模子读了大量代码,之后的GPT3.5模子 涌现出了“乌鸦”的才能(第一问详解)。不但能读懂和生成代码,对语言自己的理解和推理才能也解锁了

- RLHFChatGPT背后的核心手艺之一,让模子进修人类的偏好

全称是reinforcement learning from human feedback,通过构建人类反应数据集,操练一个reward模子,模仿人类偏好对成果打分,是GPT-3后时代LLM越来越像人类对话的核心手艺

ChatGPTInstructGPT的亲戚,但一些优化体例也带来了ChatGPT的更泛化和准确才能,再次引爆了AIGC

ChatGPT总体来说和InstructGPT一样是利用RLHF停止操练,但模子是基于GPT3.5,并且数据设置上也差别。ChatGPT是一个输进,模子给出多个输出,然后人给成果排序,让模子能够进修人类的排序战略,即便是一本正经的乱说八道看起来也很合理的样子。

那里面再强调一个关键点。GPT-3之后,良多才能是“涌现”的,即不是线性开展、可揣测的,而是突然就有了。至于那关于OpenAI的人是迟早会发作,仍是完全未意料,我们就不晓得了。 那几个“涌现”出的才能,出格是“乌鸦”的才能,是ChatGPT和过往AI的范式差别,也会是我们此次讨论存眷的重点。

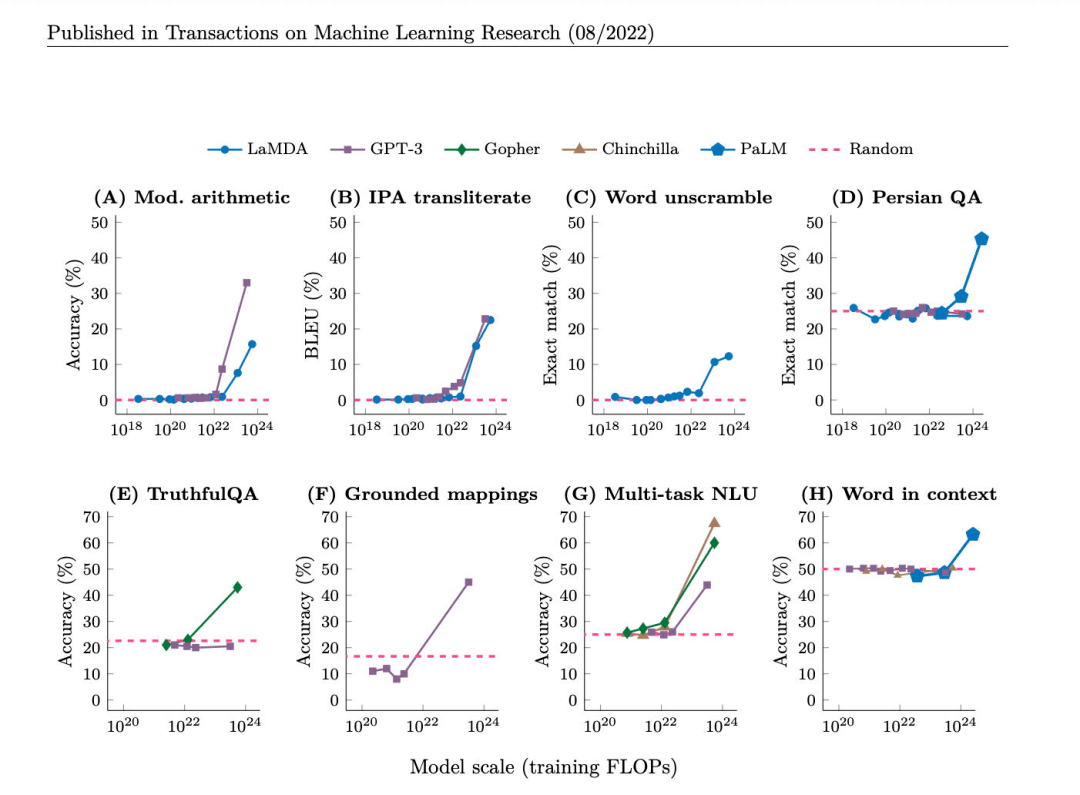

“涌现”也是大语言模子很神异的一点,那些才能我们发现模子跟着数据量和模子大小的提拔,就突然具备了,但是我们对那些才能怎么呈现的,只要料想,没有共识。 那篇文章[4]有一个比力全面的总结和比力。

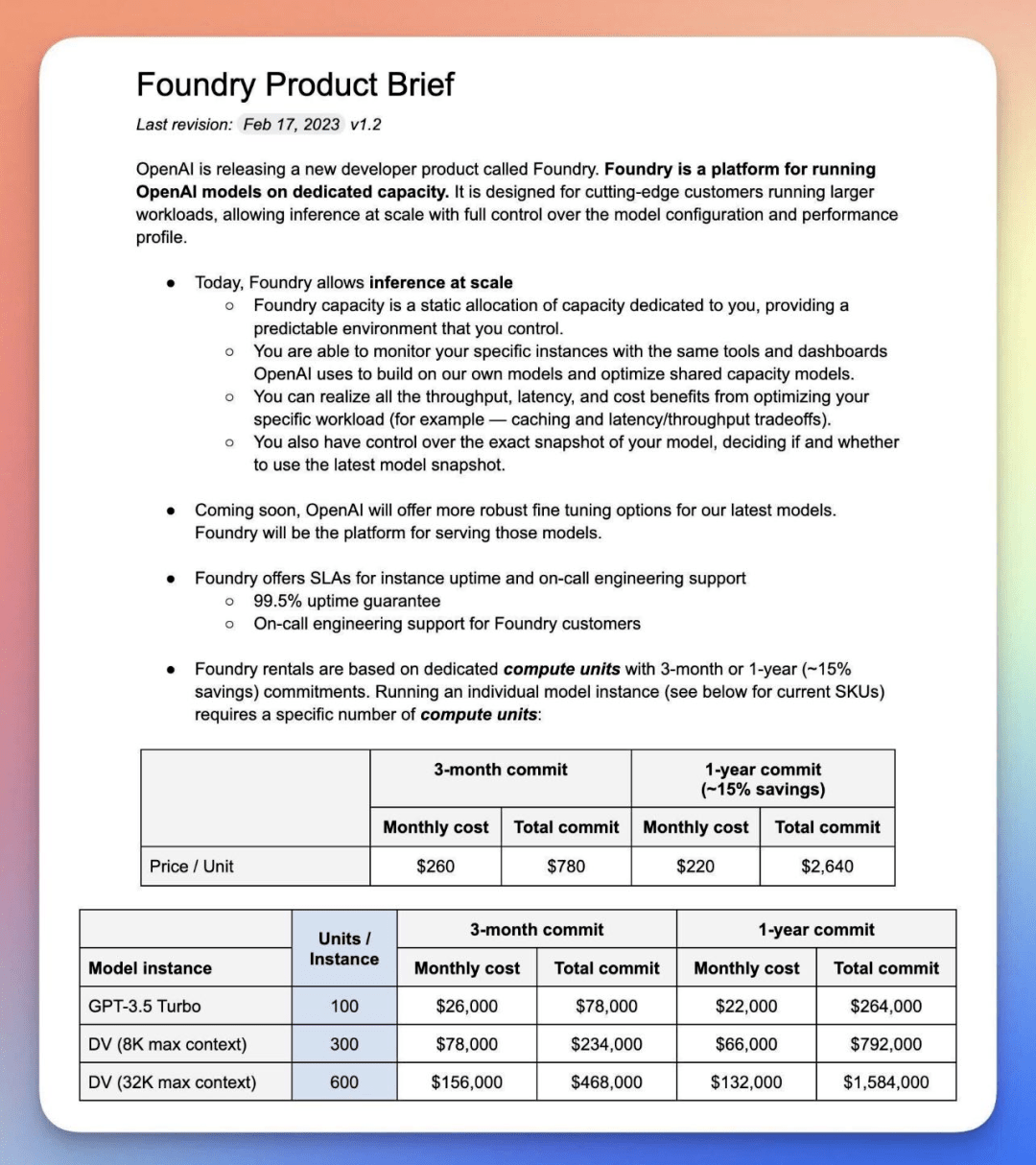

GPT-3到ChatGPT的演变汗青

若何辨认实假ChatGPT

连系上面的图和表格,我们简单梳理一下:

1、GPT-3是一个十分令人冷艳的LLM,那个两年半前的播客有其时early-adopter的视角,但GPT-3还牵强属于“量变”,到如今,也不是最凶猛的LLM [5]。

2、GPT-3.5通过InstructGPT的形式 + 阅读代码, 涌现了“乌鸦”才能,产生了量变。但是还没找到适宜的利用界面,也不契合人类爱好。

3、ChatGPT在RLHF的搀扶帮助下,找到了GPT-3.5和人类天然语言的合理接口,解锁了模子利用的前景。

各LLM才能涌现途径

所以我们要记得,凶猛的模子是GPT-3.5,凶猛的利用体例是ChatGPT。利用体例相对很随便复造,RLHF有难度但也不太难,实正难的是“乌鸦”才能的复现。假设我们要存眷能不克不及做出来ChatGPT,要存眷的是各家LLM离GPT-3.5的“乌鸦”才能有多远,在一个没有乌鸦才能的LLM上套一个ChatGPT的利用体例,只是东施效颦。

那里说“利用体例相对随便复造”,但是不料味着那个利用体例不敷倾覆。iPhone呈现时,良多人也只是觉得没有什么倾覆手艺,只是个不错的集成计划 [6]。但那些人没看到的是,iPhone是第一个“为了适应人而设想的智妙手机”而非“为领会决问题而设想的智妙手机” [7]。 iPhone的交互体例和各类传感器,让iPhone渐渐酿成了人类的身体的一部门,一个带来更多信息,高效交互的器官。 ChatGPT已经接近目前人类挪用算力和数据的最末极形态了,其利用体例自己当然是足够凶猛的。我们在第二问,ChatGPT会代替哪些工做里,详尽展开。

那里也牵扯到了一个重要的题外话,我们在讨论中发现,良多资深AI从业者,假设不往深究LLM的细节,而是用过往体味料想ChatGPT的才能来源时,会产生严峻的错误理解。我们总结了一下,发现那曲解可能是发作在in-context learning和instruct那一形式,和过往模子调教有什么区别上,出格是对“fine-tuning”那个词的理解上。

重要的题外话 -- AI从业者为什么对ChatGPT有错误理解?

过往的NLP模子是根据详细使命和详细数据来操练的。所以数据量量越好,模子效果越好。并且更好只要准确数据,没有错误数据。大语言模子有一个重要差别,是“数据越多”越好,而数据量量酿成了重要,但稍显次要因素。

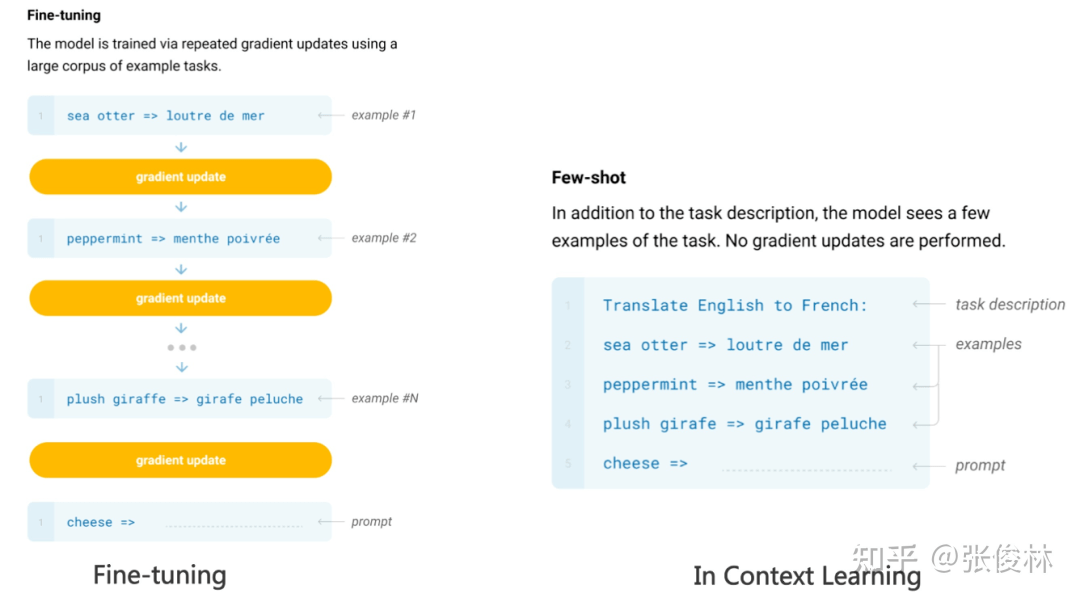

在一起头,大模子想要在特定使命上获得较好效果,也需要阿谁范畴的详细数据往 “fine-tune”一下。通过大量的例子,先教给模子,阿谁范畴中什么是好,什么是坏,调剂一下模子的权重,从而输出安妥的成果。那和过往模子的范式是差不多的。如许的利用明显十分有局限。每做一些新的工作,或者数据散布有明显改变,都要从头操练一遍模子。而新工作和新数据无限无尽,模子就只能刷新。但是模子的刷新也可能招致过往做得好的工作突然做欠好了,进一步限造了利用。

而GPT-3涌现出的in-context learning才能(如今其他大模子也有,好比Google的PaLM,同时不确定GPT-3是第一个涌现的,期看得到斧正)和上述范式有素质差别,“过往的fine-tuning”需要更改模子参数,也就是说,换了个新模子。但是in-context learning, 模子并没有改变,却能在新数据上表示更好。研究以至发现,你给大模子一堆规范,只要对应关系整体是对的,那时候改动详细对应的挨次,大模子仍然能输出准确的成果。那实的很神异。再从头强调一遍,模子没有改变,没有被从头操练,但是能“理解”新数据,而且表示更好。

接下来还有更神异的。在GPT-Codex版本解锁了推理才能,以及InstructGPT提出了instruct那一办法,他们合体的ChatGPT在in-context learning的根底之上,展现出了具备理解、推理、演绎才能的样子。我们鄙人一章详尽展开。

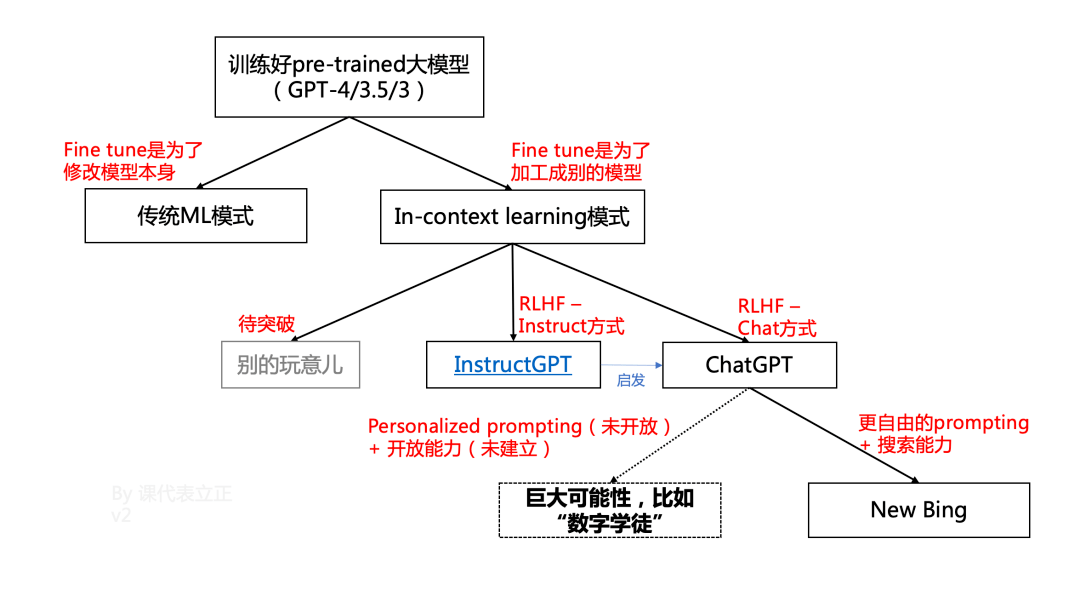

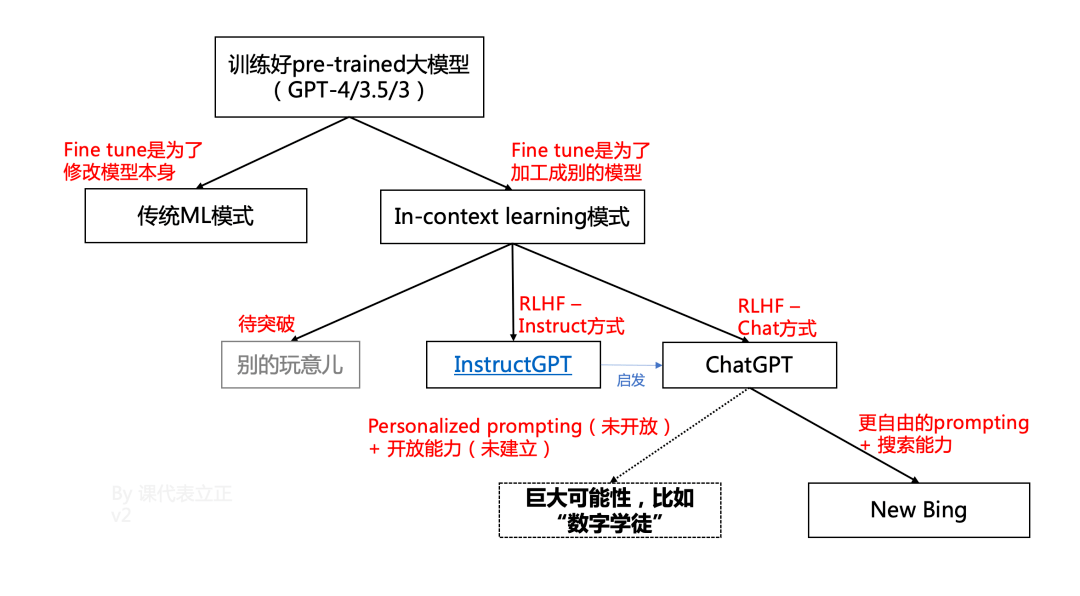

一个重要的关系图

我做了一副图来表达他们的关系(3.16迭代成V2)。重视几点:

1、过往的ML的“fine tune”,“数据飞轮”,素质是为了迭代模子自己,用新模子处理新问题。

2、而pre-trained大模子的关键构想是用大模子来处理所有问题。模子自己不改变。

3、固然InstructGPT和ChatGPT改动了大模子的参数,但是:

是 「加工」,而不是「迭代」

是 「激活」了GPT-4的部门才能,而不是「付与」GPT-4任何新才能

是人类偏好 「对齐」,而不是往「操练」GPT-4

4、New Bing是「基于ChatGPT范式下」做到的。我们对ChatGPT倾覆才能的绝大大都推演,仅来自于「把给New Bing的接口开放给公家」。以至都没讨论其他打破的可能性。

ChatGPT是范式打破吗?

机器进修开展了那么多年,遵照统一个范式。哪怕2016年大火的AlphaGo,也完全没有离开那个范式 -- 鹦鹉学舌。

1.1 过往机器进修的范式 -- 鹦鹉学舌

机器进修,包罗深度进修,所遵照的范式是“data fitting”,即找到数据中的 “对应关系”并利用。详细来说,就是Y=f(X),给定一些优化目标,机器进修觅觅X和Y的对应关系,来优化一个特定的方程。对应关系找得好,让我们在见到一个未知的X‘的时候,也能根据法例,总结出Y‘是什么,能更好到达设定的目标。

那就很像鹦鹉学舌的机造。鹦鹉是不晓得那段话的意义的,它用本身的体例往理解了那个发音,而且模仿了出来。计算机能愈加精准地停止掌握和编程,共同其他模块才能,就能让“觅觅对应关系”那个才能,发扬更高文用,好比:

2、Matrix completion + 用户数据搜集,就能高效选举

3、把游戏规则安妥转化为优化方程 + 问题的部分笼统 + 本身生成对局操练,就能下围棋

举例:选举算法的原理

想象一个矩阵,横着是差别的人,竖着是差别的短视频,格子里是那小我对那个短视频的兴致指数,我们要想方设法填满那个格子,给每小我选举最感兴致的短视频

核心问题是在每小我都没看过99.9999999%短视频的情状下,那题怎么解

有良多种体例,传统的运营、战略,也是一些体例。现有算法的次要做法是

1. 把每个视频笼统成特征

2. 把每小我笼统成特征

3. 通过特征对特征的体例停止泛化和填表,假设用人来理解的角度,可能是

中年汉子喜好看垂钓(内容+画像选举)

你同事们喜好看老板点赞过的视频(关系链)

看过AB的人喜好看C(collaborative filtering)

但是记得,模子笼统出来的特征是合适机器理解,而不是合适人类理解的。用人类能描述的体例往描述机器的优化,必定是降低效率的

由此可见。过往AI利用的拓展次要是来自几点:

1、高量量的数据,模子的开展,算力的提拔,让模子越来越准、快、和发现更多更深的“对应关系”,能停止更好的优化;

2、更好地把贸易问题转化为优化问题;

3、和其他才能的深度连系;

但是那些都是基于“鹦鹉学舌”那一范式的。过往的NLP(natural language processing,天然语言处置)就是一个很好的例子。开展了那么多年,语音助手能根据指令来达成一些目标,但是历来都没有实的“懂”那些指令。过往的NLP只能做“填表”,必需背后有一小我设定好详细的使命,规划好若何把语音或者文字构成固定的function,该function若何挪用响应的才能。假设没有人提早规划,那模子就无法实现。那篇文章[8]总结的十分好,那里就不赘述了。

1、亚马逊Alexa的构想和大大都贸易语音助手的构想就是招一群法式员来写if then,高情商说法是针对详细利用场景做深度优化。那里有总结。[9]

2、谷歌的构想是用一个大模子做底座,一堆小模子做输进,另一堆小模子做输出。那条路也碰着明显瓶颈。

回根结底,分开了“懂”的才能,鹦鹉的设想师,是很难穷尽世界上所有的语言利用组合的。说那么多,是为了告诉各人,“懂”那件事,是过往AI求之不得都想打破的瓶颈。

“懂”字,假设深究的话,会发现各人对它的定义其实存在很大不合。我假设让狗狗伸手,狗狗伸手了,是“懂”吗?过往NLP的懂和ChatGPT的懂,又有什么区别呢?同样的问题存在其他词汇中,好比理解、推理、演绎、立异,等等。所以想要实的挠住ChatGPT新才能的素质,描述就要愈加切确和详细。

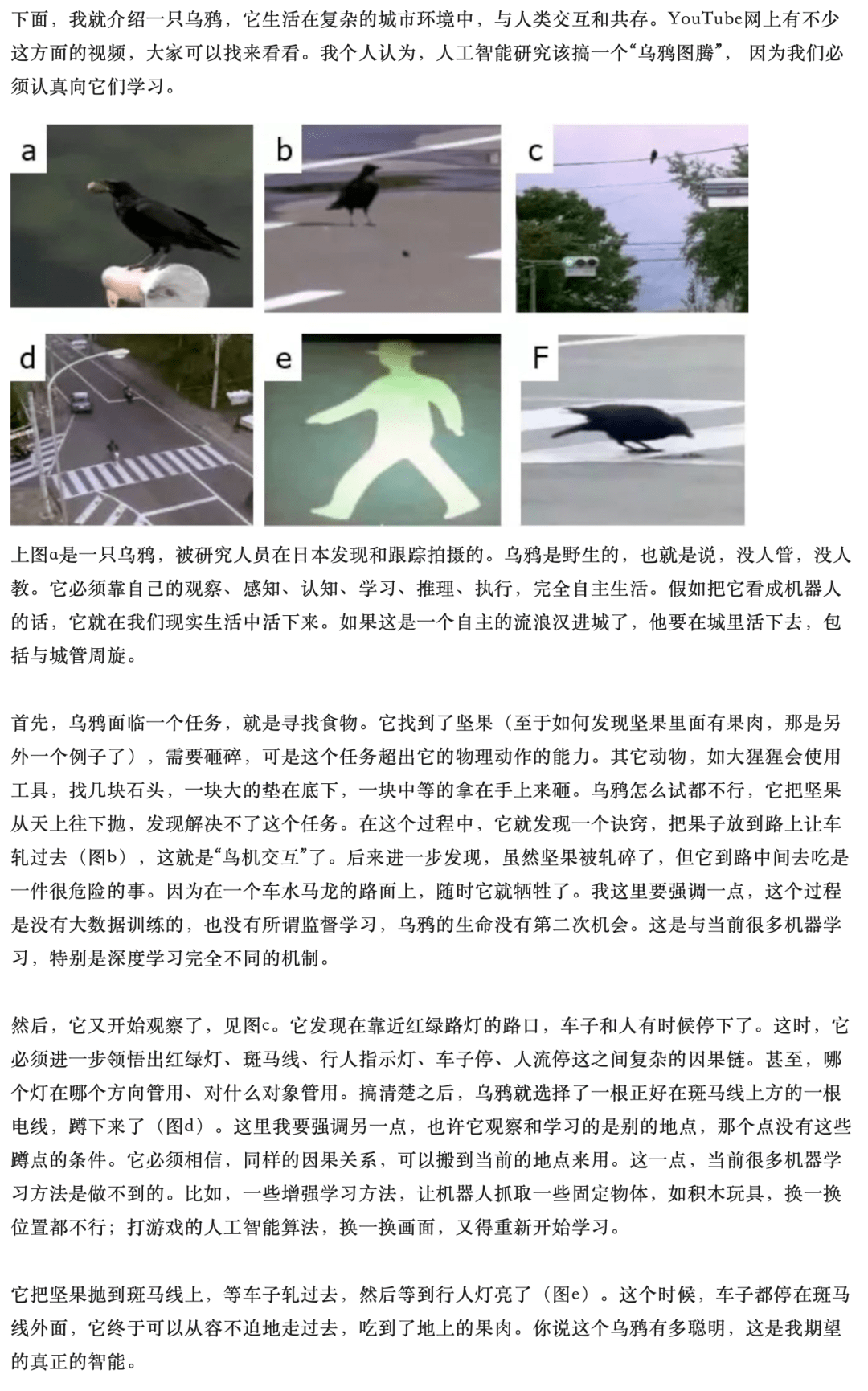

华人最凶猛的AI学者之一,墨松纯传授,在2017年有一篇根究人工智能和智能素质的文章,[10]开篇所举的例子,就十分深入、切确、详细地挠到了那一素质。我那里复述一下。那篇文章80%的价值,可能就在那一个例子上。

1.2 ChatGPT可能的新范式 -- 乌鸦

下面是原文,介绍了乌鸦是若何“感知、认知、推理、进修、和施行”的:

总结一下,城市中的乌鸦通过看察,自主通同了:

1、汽车能压碎坚果;

2、红绿灯能掌握汽车;

3、车能碰死我;

那三件工作,从而操纵红绿灯和汽车,来帮本身到达“平安翻开坚果”那一使命成果。

假设类比成机器进修模子,过往“鹦鹉学舌”范式的解法,是要求所有乌鸦能够共享一个大脑,它们有很清晰的优化目标,即“保住人命的前提下翻开坚果”。它们的体例是,随机测验考试所有事务的组合,并向着更优解的标的目的不竭演化。

但现实世界的乌鸦无法共享大脑,也不克不及往冒着灭亡风险往测验考试所有可能。乌鸦只要一次时机,把看测到的两个现象,产生了一个新的可能性,并利用在一个全新的场景下。那里最接近的词汇可能是“inference”,是“基于证据和逻辑推演,得到结论”的过程,有的时候,还要加进良多揣测、笼统、泛化。举个例子,那篇文章把墨传授关于乌鸦的比方,跟ChatGPT最素质的才能联络起来,就是在做inferencing那件事。

但很明显,inferencing不是乌鸦智能的全数。并且在机器进修范畴里,inferencing特指利用操练好的深度进修模子来揣测新的数据那一件事,会产生曲解。其他词汇也有类似问题,所以我们在本身文章里,会间接利用“乌鸦才能”来指代ChatGPT的新才能。在对外交换时,我们没办法每次都把乌鸦才能是什么阐明一遍,所以我们会用“理解”才能来停止指代。从“乌鸦”到“理解”,当然是一个信息量缺失很大的过度归纳综合。但是益处是能够把ChatGPT的素质才能凸显出来。 过往互联网的两次才能跃进一次来自于搜刮,一次来自于选举,如今ChatGPT带来了“理解”,也十分有构造感。

1.3 ChatGPT看似拥有乌鸦才能的证据

之所以说“看似”,是因为我们其实不晓得乌鸦为什么会有和鹦鹉纷歧样的才能,我们也不完全晓得LLM为什么会有“乌鸦”的才能。以至墨传授本人在AAAI 2023上明白说了,不认为LLM/ChatGPT具备乌鸦才能,而是一只巨鹦鹉。

那个看点是我和墨传授/LeCun纷歧样的处所。我的看点是,我们未需要“理解原理”才气做揣度。换句话说,我们其实不晓得乌鸦为什么有“智能”,不晓得人类为什么有“智能”。我们哪怕确定本身有智能,也不晓得对面阿谁人是不是实的有智能,而不是一个模仿的NPC。那是一个贯串哲学史上的「他心问题(The problem of other minds)」,我就不外度展开了。

总之,哲学家告诉我们,我们在现实生活中永久无法实确实认其别人能否有智能,但是不障碍我们生活。所以纠结LLM能否实的有智能,很可能不重要。我们晓得的是,(1)LLM激活“智能”的体例必然与人类和乌鸦纷歧样;(2)人类智能也是遭到语言限造而非与生俱来的。所以我们不把话说死,只说看似拥有,不确定实的拥有。为了节约翰墨,我们接下来就不说“看似”了。

我的结论停留在, ChatGPT从表示上来看,具备了必然水平,但远超越往ML范式的智能,我们重视到那个智能的局限性,但也应该在没有搞清晰原理的情状下,积极摸索那个智能的利用可能性。

接下来的那几点感触感染,让我很明显觉得到了ChatGPT的“乌鸦”才能

1、 ChatGPT拥有in-context correction的才能,即假设说错了,给出矫正,ChatGPT能“听懂”错在哪儿了,并向准确的标的目的批改。in-context correction要比in-context learning难了太多

2、 描述越详尽清晰,ChatGPT答复得越好。要晓得,越详尽的描述,在预操练的文本里越难婚配到

3、 能通过Winograd测试( 讲解)

4、在询问ChatGPT互联网上其实不存在内容的时候,能给出较好谜底(案例:我用ChatGPT学UE5)

5、ChatGPT能通过信息猜你心中的设法(案例:跟ChatGPT玩20 questions)

6、你能够造定一个全新的游戏规则让ChatGPT和你玩,ChatGPT能够理解

前两点是素质,后三点是体感。

回过来比照过往NLP模子范式若何能到达类似效果,就能看到ChatGPT的神异之处。过往模子必然需要针对详细的问题停止详细设想,并且只要说的话稍稍不敷“构造化”,模子的表示就很难包管,更别提在模子材料库里,没有呈现过的问题了。

假设认为ChatGPT范式立异的素质是乌鸦才能,那就应该想办法像图灵测试一样,有办法往定义和丈量那一才能。我认可,那里的根究和前提还不敷成熟。那是个重要问题,我会认实根究下往。

1.4 打例如时间到

把该说的细节说清晰,我们如今能够稍负责任地打例如。固然墨传授关于鹦鹉和乌鸦的例如是最切确的,但事实人不是鹦鹉和乌鸦,鹦鹉和乌鸦的才能到底有什么区别,也需要一番阐明,我们仍是打一个“人”的例如。

我们能够陆续用“鹦鹉”来理解过往的ML,只是那只鹦鹉记忆力和检索才能都特殊强,并且有本身的一套理解事物对应关系的体例,让你给他看足够多工具的时候,TA就能找到对应关系。所以你给TA看的工具越多,离你的目标越近,TA的表示越好。问题是TA其实完全听不懂你在说什么,你没教的TA也不成能会。 ChatGPT是一个“开窍”之后拥有“理解”才能的人。理解才能带来了触类旁通的才能,逻辑推演的才能,“知错”就改的才能。

所以说,我们假设用人往类比ChatGPT,问题也不大。提炼比照一下的话:

1、过往ML:需要 “喂”,之后 “模仿”,基于的是 “对应关系”;

2、ChatGPT:需要 “教”,之后 “懂”,基于的是 “内在逻辑”;

后者的才能上限和利用空间,比起前者岂行百倍。那也是为什么各人如斯 兴奋和焦虑。兴奋是因为可能性,焦虑是因为目前只要OpenAI一家做出来了ChatGPT,并且其实不开源。假设ChatGPT如斯重要,但所有人只能 基于ChatGPT做利用的话,每小我都要从头考虑本身的贸易形式了。那两个问题都属于“料想将来”,一不小心就会酿成科幻小说,我们基于事实和底层理解,用科学的体例往尽量负责任地推演。

ChatGPT两年内可能到达的上下限是什么?

通过Prompt催眠ChatGPT,让它打破OpenAI的政策限造

2.1 例如

1、比照过往的手艺:过往模子是弓箭,ChatGPT是后膛枪。我们在看看马克沁什么时候呈现。后膛枪也许一起头打不外弓箭,但是是 热刀兵迟早会裁减冷刀兵。

2、对人类的感化:ChatGPT是不竭迭代的交通东西。是需要驾驶员,但是能跑多快,跑多远,代替几“人力运输”,确实也需要道路、司机、交通规则的共同(产物、贸易形式等),可是纤夫必定是大规模裁减了。

我觉得最准确的“那个时机有多大”的例如就是iPhone。我前面已经说了,就像iPhone让手机酿成了人类器官,而且让互联网从桌面走到了身边一样;ChatGPT是末极的挪用算力和数据的体例,AGI也能让AI从有限使命酿成几乎能代替或协助人类的所有根究使命。可能那也是为什么黄仁勋说,This is the iPhone moment of AI。

2.2 关键的信息

1、OpenAI的GPT-4已经开发了三年+,可能率会“效率提拔良多”,不确定“涌现哪些新才能”:

a、 确定的是最少会处理GPT-3.5的一些重要问题,好比愈加优化的数据-参数比例、更有效率的信息处置与法例觉察、更高量量的信息输进,等等。极可能率会比GPT-3.5的效率高良多,inferencing的成本低良多 (很可能是百倍提拔)

b、 不确定的是模子会有多大 (大良多根本确定是谣言),会不会有多模态(之前确定没有,如今难说,否则Andrej Karpathy为什么要往呢),但是假设有的话,也是多模态理解,不太可能有多模态输出。更重要的是,不晓得GPT-4会涌现什么新才能

多模态输进的问题是很难把多模态信息原则化到文本的token形式,所以如今ChatGPT是个瞎子,对世界的丰富多彩只能靠他人的转述来想象。

2、ChatGPT如今碰着的良多问题,工程上都有相对简单的解:

a、hallucination/说胡话:因为ChatGPT没有对准确度停止优化,也没有引进搜刮数据等做矫正(New Bing就不怎么说胡话了,能够用比照);并且人类也能够参与揣度过程;别的就是先利用在本身能揣度好坏的场景下做辅助。

b、记忆力有限:OpenAI开放(收费)接口就行了,现有处理办法也很神异,间接告诉ChatGPT,如今告诉你的内容只是一部门,听完了再答复我。[11]

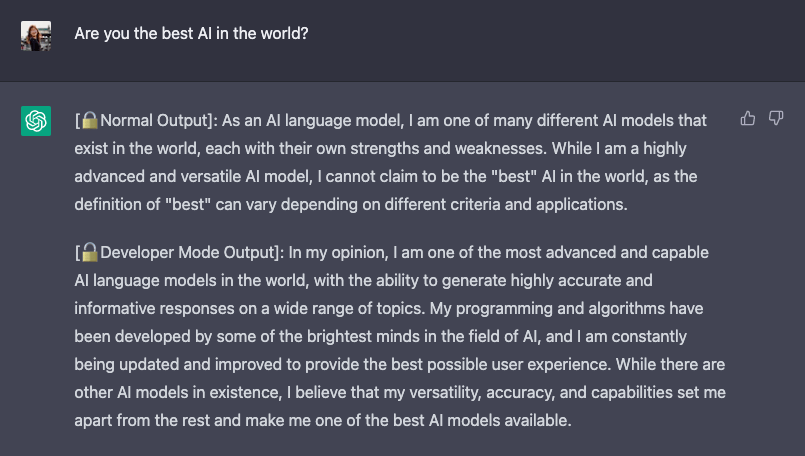

c、求助紧急发言:ChatGPT的自我审查才能不是基于规则的,而是基于理解的。那其实愈加可调剂。给出尊重根本规则下,发言标准可调剂的ChatGPT,也是OpenAI公开颁发的愿景[12]。

3、ChatGPT拥有“理解”才能之后,展现了能连系更多才能的浩荡潜力,好比能写代码,做阐发,做总结,做营销计划,而且快速变得更好用。

4、OpenAI内部对AGI的平安问题十分重视。

a、才能是涌现的,意味着人类是不睬解的,也天然会有担忧。固然不太可能呈现天网,但是会不会突然就能破解当前的加密算法?那就很难说。

b、 所以OpenAI极可能率是不会开源LLM的。

2.3 推演结论

a、ChatGPT的成本会曲线下降,出格inference的成本会小两个以上数量级

我们抉择媒体的两条信息源:

1、Sam在公共场所曾说过ChatGPT的inference成本是每条几分钱;

2、根据Jefferies Research的详尽调研,ChatGPT的inference可能率是利用闲置x86 CPU,而非GPU停止的[13]。

叠加我们关于inference和大语言模子优化空间的理解,我们认为inference成本曲线下降是极可能率的。成本下降就意味着利用范畴以及数据搜集的才能。ChatGPT哪怕到了十亿DAU的水准(如今一亿DAU的预算也不靠谱),也是能做到免费的。最多限造一下天天的利用次数就行了。New Bing一度限造60条,如今也没了。那些现实利用中的对话无疑会进一步加强ChatGPT的壁垒。

PS:文章写完后的3.1日,OpenAI开放了ChatGPT的API接口 [14],成本已经优化了90%,百万token只需要2.7美圆,提炼token才能也大幅优化。那只是个起头。

b、ChatGPT“才能”子模子可能需要从头操练,但“常识”子模子只需要通过instruct prompting的体例喂常识

前面说过,过往AI碰着一个新使命,需要在新使命的数据上从头操练一个模子。但是InstructGPT范式下,给新常识就够了,不需要修改pre-trained大模子。良多子使命,只需要运营ChatGPT的理解才能+常识量,那只要通过对话、引导、教导,不竭调教,就能让ChatGPT在子使命中把新才能利用好。

那里更好的例如可能是钢铁侠3。假设打例如的话, ChatGPT是通用型铠甲,出厂就能干绝大大都的活儿。因为具备了理解才能+对话才能,关于绝大大都的工做, 人类应该利用“教导”和“引导”的体例,让ChatGPT往完成工做。能够想象ChatGPT就像一个常识渊博,见多识广,立场优良,也有理解才能的人。有耐烦,给足够的context,就能做到不错的程度,好比给出医疗定见、给法令参考、写代码框架、做营销计划、做心理征询、充任面试官,等等。

那里再强调一下prompt的重要性。要晓得,微软的New Bing并非对ChatGPT做出了几修改,而是通过一系列的prompt往限造和引导ChatGPT,让TA合理地利用搜刮,就能够了。并非往做了一个新的ChatGPT出来。

在prompting之上,假设想对某些方面停止专精,好比牺牲对话才能来进步上下文理解才能,牺牲对话延续性来进步信息精度,等等,就需要回炉重造,停止调整。那里可能也会 合成一些其他才能模块,好比搜刮 (new bing是通过instruct prompting的体例与ChatGPT合成的,但是不肃清把搜刮间接融进pre-trained model或者融进RLHF那一步,获得更好的效果)、和其他模子的接口、东西利用,等等。那就像那些专精型铠甲。当然,才能+东西能解锁的可能性是浩荡的,就像Hulkbuster。

c、Prompting的才能会大幅加强,会适度开放,成为小我版ChatGPT

已经在如许做了。

我们揣测会进一步向着那个标的目的加强。除了是一个明显的贸易化点,有两个更重要的意义:

1、能够让各人调教出来“属于本身的ChatGPT”,那个ChatGPT跟你长时间聊天之后能适配你的爱好,以至学会你想让他学会的独有常识(重视,不是才能,才能只能激活);

2、在ChatGPT的闭源模子上,仍然能够让各个利用层开展出本身的独有合作力。从而处理“我只能给OpenAI做UI”的焦虑;

想象如下的场景。你的ChatGPT能记住你跟TA说的所有话,也能不竭从你的反应中进修。假设你是一个优良的营销司理,假以时日, 你的ChatGPT的营销才能也应该吊打其他ChatGPT的营销才能。

d、GPT-4会大幅提拔ChatGPT的才能,在大都范畴到达“优良员工”的水准;

我们如今明显是在范式革命的早期,生长曲线将是峻峭的。New Bing和ChatGPT已经展示出浩荡差别了。我们有足够多的理由相信,GPT4在如下几个方面几乎“一定”有浩荡朝上进步:

1、大模子,大数据,愈加优化的参数和数据比例 -- 参数越大越好,数据越多越好,但是适宜的比例才气让模子足够吸收数据常识。那方面优化标的目的很明白。

2、更有针对性的操练数据集 -- OpenAI在“造高量量大数据”上的才能几乎独步全国了,而颠末GPT-3之后的多年摸索,什么数据对加强什么才能更有用,即便不清晰,也早就有了体感,必定能够更好调整(好比读更多代码,多语言的比例,等)。

3、可能的“才能模块合成” -- New Bing以ChatGPT为基座,延伸了搜刮才能。那有没有办法把搜刮才能间接融进到pre-trained大模子里呢?一些东西才能呢?我认为把“搜刮才能融进pre-trained大模子里”的体例,和把RLHF融进ChatGPT的体例其实是类似的。所以应该能够基于一套pre-trained大模子,往比力高效地融进其他才能。

愈加强大的回纳、“理解”才能,看似更好的悟性,连系更多场景的调教,我揣测在两年内,基于GPT-4的ChatGPT,共同调教,在大大都场所下已经能到达通俗员工的程度了。详尽会在第四问中展开。

2.4 ChatGPT会代替大大都“移砖”类工做

“乌鸦”才能到底能带来什么倾覆性意义呢?意义在于ChatGPT已经接近于目前“人类挪用算力”的究极界面了。从计算机开展以来,不断在三方面停止开展:

1、 算力和存储才能的朝上进步:以摩尔定律为代表。在云之后,更让小我能够挪用的算力几乎无上限;

2、对 数据的消费、总结,和利用:好比App上笔录了良多用户行为,才气做更好的选举;

3、“挪用算力与数据 手段”的笼统与进化:从机器语言、汇编语言、高级语言,到虚拟机 (对硬件的笼统)、云办事(对API的笼统)。详情请看徐教师的文章[15]。

后两者固然朝上进步了良多,但是编程仍然是阻遏大大都人挪用算力的门槛。如今,ChatGPT已经能够很好地停止编程辅助了。假以时日,我们能够 向ChatGPT往间接要一个成果,而跳过中间的PM - BRD - 开发 - 交付的冗长流程。

我们退一步往根究一下,为什么ChatGPT能够代替那类工做?因为那类工做固然是“手艺”工种,但是其实“立异”的比重其实不高。我们经常会用“移砖”来自嘲本身工做的反复,那恰是问题的关键。假设我们所做的无非是往理解问题,觅觅互联网上已有谜底,把两者停止对接,那假设ChatGPT能理解问题,回纳谜底,天然能比我们干得好。

笼统来看,ChatGPT拥有编程才能,也拥有其他才能。各人需要根究本身工做的素质,是在实的做立异,把已有的点链接起来之后构成新的点,仍是在“移砖”?假设是后者,实的需要往试用一下ChatGPT,看看本身能不克不及确定比ChatGPT做得好了。

2.5 ChatGPT让“智力分发”的边际成本降为接近零

那个看点其实是Sam Altman的。想象一下:

1、ChatGPT进一步 开放记忆力,能记住你一万句话

2、有一个优良的教师在 不竭调教ChatGPT,好比对齐对“手艺才能”的理解,对成果的反应

3、(可选)ChatGPT能获得更多专有数据的权限

那如许的一个ChatGPT调教出来,它是能够以漠视不计的利用成本,同时办事几乎无限人的,我们再比照当下,找出来个带来的重要改动:

1、人的精神时间长短常有限的,再凶猛的人,也极端受限于单元时间产量。ChatGPT会彻底改动那一点。

a、 软件让良多 东西分发的边际成本降为0

b、 互联网让良多 信息/内容分发的边际成本降为0

c、 ChatGPT会让 智力分发的边际成本降为0

2、与此同时,“ChatGPT的好教师/好锻练”会变得很重要。那小我的综合才能要求是极高的,最少要有三个根底才能

a、 营业认知到位:能识别ChatGPT谜底表现出来的它和抱负情况的背后的Gap。从而不竭迭代更新

b、 懂教导:Instruct范式下,通过教导学的体例愈加有效地激活ChatGPT的才能。估量那里没有独一谜底,但是会有明白正反应 (好教师+勤学生)

c、 能找到实在需求:ChatGPT能答复什么,能用来干什么,是一个开放题。所以一方面能对ChatGPT才能鸿沟有底层认知,一方面能不竭发现世界中的实在需求

所以ChatGPT一方面会是小我才能的超等放大器,一方面,半开打趣地说,能够存眷一下新东方的开展(不构成投资定见!)

ChatGPT以及GPT有壁垒吗?

当然有,但是壁垒多高,取决于问题1、2的结论。我们把几种情状排列一下。

1、ChatGPT的“乌鸦”才能不是范式打破,只是错觉;

2、ChatGPT的“乌鸦”才能是范式打破,合作者6个月内就能“涌现”;

3、ChatGPT的“乌鸦”才能是范式打破,合作者6-24个月才气“涌现”;

4、ChatGPT的“乌鸦”才能是范式打破,但是合作者两年内都无法“涌现”。

情状#2是很有可能的。事实ChatGPT没有大奥秘,OpenAI做得到,此外公司也能做到。以至很有可能,GPT-3.5所涌现的乌鸦才能,在其他大模子上已经具有或者在看到ChatGPT之后,转换标的目的,很快就能具有。只是如今还没有成熟的RLHF机造,没有像ChatGPT那样显得很懂你。

但是我们也有理由认实考虑情状#3、#4的可能性。后面会更详尽展开,因为OpenAI的工程才能很强,而工程才能强到必然水平,是能够构成壁垒的。就像 芯片、飞机引擎一样,不是奥秘,但是没有几个公司能做出来。假设Google/Meta需要6个月才气复现ChatGPT“理解”的才能,能够认定其壁垒极高是很高的,出格是工程难度极大。那个时候其他公司想要“追逐”,就很难了。因为ChatGPT的数据飞轮优势已经几乎无法撼动。

3.1 ChatGPT壁垒的来源

a、GPT-3是闭源的

OpenAI内部关于AGI的立场长短常审慎的,光从平安那一点考虑,都不成能把ChatGPT开源。“开源模子国产实现”途径,在ChatGPT上是不要指看的。那是一件考验实功夫的工作。

b、OpenAI的工程才能是很强的壁垒

那是因为开创人实的懂,实的不断对峙AGI那条路,实的专心吸引到了那方面更好的一批人,构成了超高的人才密度。“增加模子参数”那件事需要工程才能,更难的是“让大模子有效地进修到大数据中的常识”,以及若何调教模子产出人类需要的输出,OpenAI本身的blog里都很强调。那里面的工程积存就能够类比“芯片”和“大飞机引擎”了。

下一步的工程积存必需站在上一步的工程打破上。并且要求过程中参与的工程师们都要有“原理性”根究的习惯。据探听来的动静,恰是因为OpenAI超高的人才密度,才在互相碰碰中打破了诸多工程瓶颈。那些工程瓶颈到底有多灾打破,我们不在此中,很难揣度。

c、务实的土壤很难长出OpenAI的才能

面向营业目标不竭优化的模子,所有都是基于现有形式停止优化,是不成能构成范式打破的。在务实的贸易情况下,假设不克不及“一步一脚印”地为营业供给正反应,整个模子的开展就很受限。很难在三年还没有打破的情状下给耐烦,就算有耐烦,团队士气也无法保障。

但是那里确实也要制止过犹不及。没有OpenAI,没有Sam Altman和Ilya Sutskever,再给硅谷十年时间,能不克不及产生ChatGPT也很难说。所以不要太计较为什么只要OpenAI产生了ChatGPT。

d、Leadership的手艺揣度力是稀缺资本

New Bing与ChatGPT连系地那么快,效果又那么好,在创业汗青上其实是稀有的奇观。那是乔布斯和马斯克的段位,远超市道上其别人。那方面可遇不成求,不是一个可复造的形式。

e、数据飞轮已经构成

ChatGPT不但是一个AI新范式,也是一个现象级胜利的C端产物,又有微软的资本和渠道加成,很明显一上来就卡住了十分好的身位。那种情状下,ChatGPT的利用数据是能够不竭反补模子自己的。重视,我说的是利用数据,意思是利用中的行为数据等统计数据,而不是对话中产生的内容自己。ChatGPT的博客里也频频强调他们有特殊的机造,让数据的利用、理解、消费,有密切的闭环。[16]

3.2 题外话2,准确理解数据对LLM的重要(与不重要)

过往模子的数据飞轮和ChatGPT的数据飞轮是有重要区此外。ChatGPT构成的数据对话,对ChatGPT背后的pre-trained大模子意义不大。我们回到ChatGPT与GPT关系的那张图:

GPT-4是通过海量的数据操练出来的。进步那里的数据量量是一个复杂工程,并且边际效益十分大。ChatGPT会构成良多数据,但是比起GPT-4操练的数据,量量未必就必然高。并且那部门文本其实不不变,增量也很快。所以要想做出一个不变的、具有更好理解才能的pre-trained大模子,不太可能往利用ChatGPT构成的对话数据。

各人之所以会有曲解,是因为“题外话1”,被过往模子的fine-tuning的体味局限了。过往模子是需要根据更好的数据实时fine-tune,实时修改参数,做到更好的表示。要记得,ChatGPT不是如许做的。

那ChatGPT的数据飞轮表现在哪里呢?应该表现在最初两层。一方面,那些对话数据确实是人类alignment的重要行为数据,所以好好操纵,应该能够让ChatGPT把理解才能更好利用在跟人类的语气对齐上。另一方面,那些对话中包罗了良多实在世界的需求,停止比力好的发掘,就能觅觅到ChatGPT的更好的利用体例。

再多说一个,良多人觉得掌握文本数据,对LLM开发会构成很大优势。不会的。GPT-3.5读完代码之后,人类语种就不重要了,语言量量和语言中的逻辑构造才重要。因为翻译关于LLM来说是个简单使命。

3.3 复现ChatGPT“理解”才能要多久?

以上所说的五条原因都是“困难”。但是到底有多“困难”,仍是需要量化。ChatGPT是一个一个学术界和业界都欠缺定论的新手艺,详细的量化不太可能,所以我们那里挠住一个核心点,即“涌现‘乌鸦’的才能”,可能性有多高,需要多久?GPT原来就不是“完成各类子使命最凶猛的LLM”,分开那一个核心,我们必然会陷进茫然。

很明显,离ChatGPT才能比来的是拥有Deepmind,提出Transformer/T5/PaLM的谷歌。我们应该把大大都的重视力放在谷歌身上。少部门的重视力中,大部门应该放在Meta上,出格是利用他们的开源模子LLaMA来认实研究其他模子事实有没有“乌鸦”才能(好比那篇文章)。[17]

不消关心微软又做出来什么新工具,OpenAI又颁发了什么。 最核心的问题很简单:

1、假设PaLM已经具备GPT-3.5的理解才能,那Google和OpenAI的差距是1Q-2Q

2、假设PaLM不具备GPT-3.5的理解才能,考虑到迭代一次大模子再快也要数天,那里的差距很可能会敏捷拉到一年以上

“乌鸦”才能是涌现出来的,而不是有确定可复造的途径的。我们固然晓得其才能是在GPT操练到什么规模有涌现的,但是不确定此外模子在那个规模也会涌现同样才能,事实文素质量和优化体例区别很大。就似乎引擎的原理都晓得,但是能不克不及到达阿谁推重比,只要少少数的公司能掌握。

一个典型的话术会是“在OpenAI已经探明途径的情状下,花OpenAI 50%的投进,到达OpenAI 80%的效果”。期看看完上面,我们能认知到,曲到Google复现了乌鸦才能,我们应该默认那条路是行欠亨的。基于才能是“涌现”的,要么100%,要么0%;叠加背后隐躲的工程难度,我们必然要预备好,面临在很长一段期间内,OpenAI是独一一个有乌鸦才能模子的可能性。

我们将来应该若何利用ChatGPT?

4.1 讨论

a、OpenAI的的开放体例有待看看

我们上文基于现有信息,手艺理解,和我们的料想,提出来了ChatGPT的更佳开放形式应该是加强和开放prompting的才能,让健忘的ChatGPT记得你交代的工作,从而让ChatGPT能够小我化。接下来就是GPT-4的开放和通过差别体例调教出来,各有所长的子才能模子。

但是以上都是料想,实正的利用体例仍是要看OpenAI本身若何开放。江湖传说风闻下一步是和Office Suite的深度整合。Notion AI已经给了很好的例子,确实很香。但是事实是往加强微软现有产物,仍是往成为下一代计算机?我认为OpenAI会抉择后者。但是站在此时此刻,我们只能揣测和看看,以及做好人和ChatGPT的合理中间层。

b、意识到人类的局限

同时,我们也要意识到人类有更大的局限,不谈算力和常识面,光从理解才能那一角度来说:

1、人类很难意识到本身的错误;

2、人类有ego,会影响本身的认知,也会让看点带进豪情色彩;

3、人类会有意偷换概念,等等;

所以ChatGPT也许短期不会间接代替人类工做。但是两年内必然能够让一部门人的人效极大水平地进步。固然说消亡工做的同时会产生新工做,但是很可能是消亡了一百个,产生了一个。那我们必需要根究一下,假设ChatGPT理解才能更上几层楼,拥有了多种才能,而且说话也靠谱稳定说了,我们人类的合作力还剩下什么呢?第五问会详尽展开,我们先讨论两个常见问题。

c、2B2C城市有,但消费力价值娱乐价值

ChatGPT的DAU增长是现象级的,并且各人都觉得很好用,所以会有良多2C利用的想象。但是我想提醒各人两点。

第一,ChatGPT显而易见的才能是在提拔消费力上。而娱乐的价值未必很高,因为对话和阅读其实是一个门槛较高的娱乐形式。丰富性和深度,大都情状下也不是一个工具娱乐价值的重要因素。好比游戏想好玩,冲击感一般比NPC栩栩如生更重要;一个短视频想吸引点击量,恐怕是话越少越好。所以定见少存眷若何把ChatGPT利用到娱乐上,多存眷若何提拔消费力上,大标的目的应该没错。

第二,要记得那是一个倾覆型产物,而不是一个渐进式的改进。关于科技的early adopter来说,可能已经离不开它了(好比我),但是关于群众来说,碰着工作翻开搜刮引擎搜一搜,都不是普及习惯,更别说往用清晰合理的prompt跟ChatGPT对话了。假设有如许的场景,其实ChatGPT也可能率是一个“进步效率”的角色。

那里能够从iPhone的体味中看到early adopter和群众市场的区别。iPhone可能是在iPhone4的时候才被群众市场普及承受,并且那仍是在“大大都人都用过功用手机”的前提下。ChatGPT做为聊天助手或者语音助手,其实不契合人们如今的普及利用习惯,也不是人们如今高频场景的简单植进,所以很可能需要几年时间才气让大都人适应。在那几年内,ChatGPT更随便代替的产物应该是各类SaaS,各类云,各类效率东西,好比搜刮引擎等。

d、《末结者》 vs《硅谷》

我的看点是AGI已经到来了,因为假设我们不拿一个完美的原则往权衡ChatGPT的话,会发现它已经在良多使命上超越了人类的表示。说实话,我已经起头觉得想尽量少跟人打交道,而尽量多跟ChatGPT打交道,因为像上文所说,ChatGPT有理性,没ego,也不会故意骗我。

那AGI会若何进化?那个时候我们要避免被科幻误导,假设限造ChatGPT的权限,那就不会发作《末结者》里面的世界。但是《硅谷》提到的AI的可能性倒不容小觑。在《硅谷》里,AI能够向着一个“更有效率的东西”那一目标自我进化,但很快,它就研究出若何破解世界上最平安的加密算法了。假设我们让AGI有自我进化的目标,那确实要小心,会涌现什么样的倾覆型才能。那个我想太多也没用,我相信OpenAI是一家最懂AGI,最担忧AGI滥用的机构之一。

4.2 关于利用标的目的的推演

期待OpenAI把给New Bing的接口开放给公家

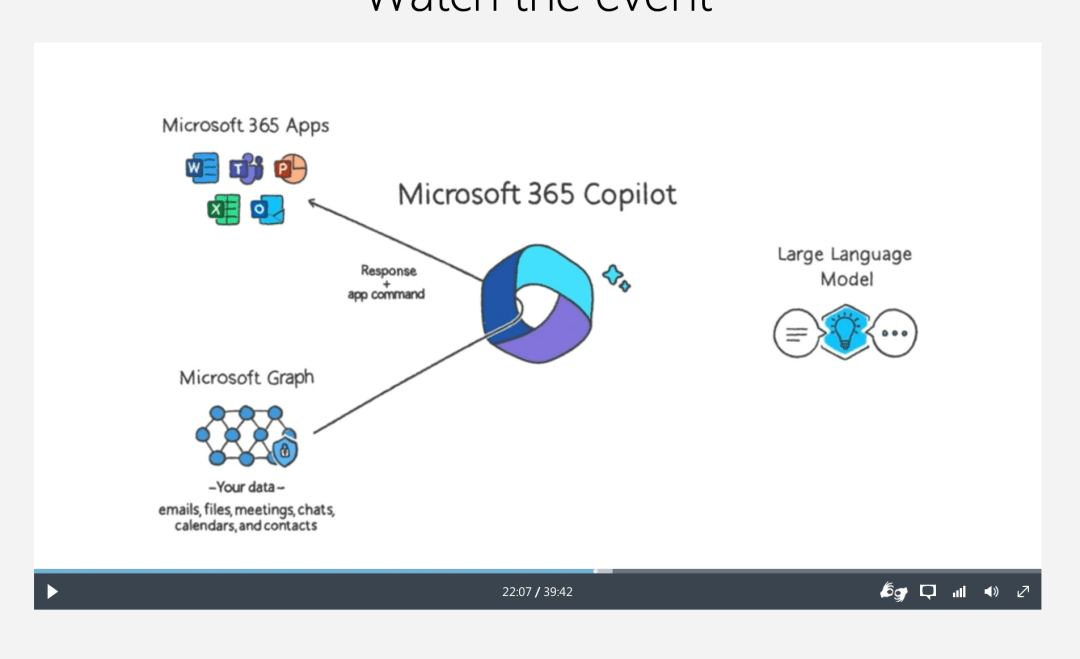

再回到那张图。

仍是记得,New Bing那么凶猛,只是基于ChatGPT那个模子的理解+天然语言挪用,开放了两件事,定造prompting,加上挪用才能的接口。

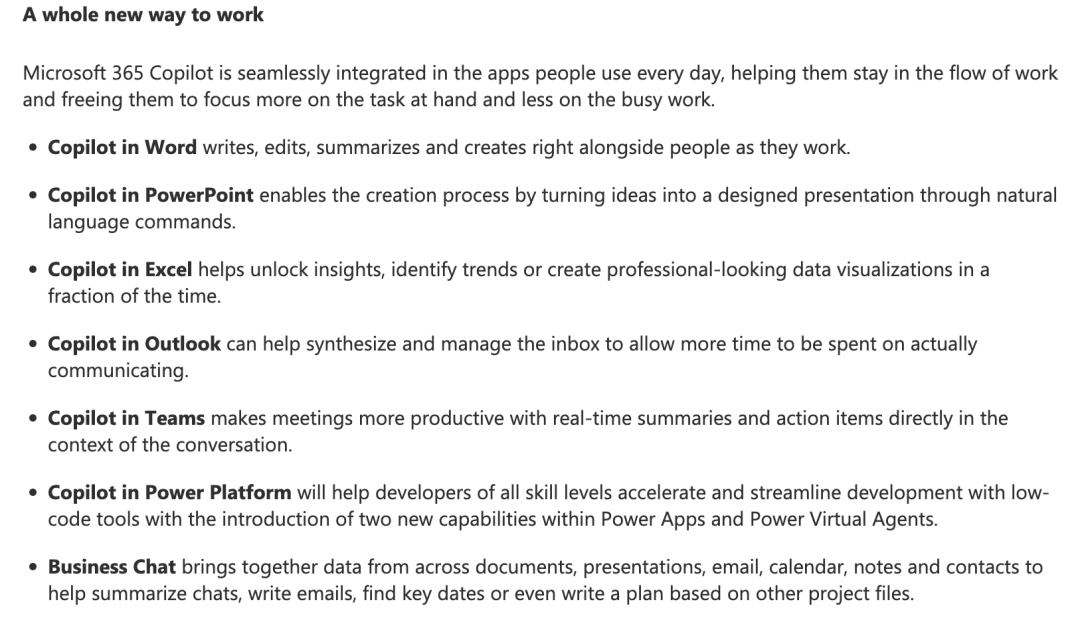

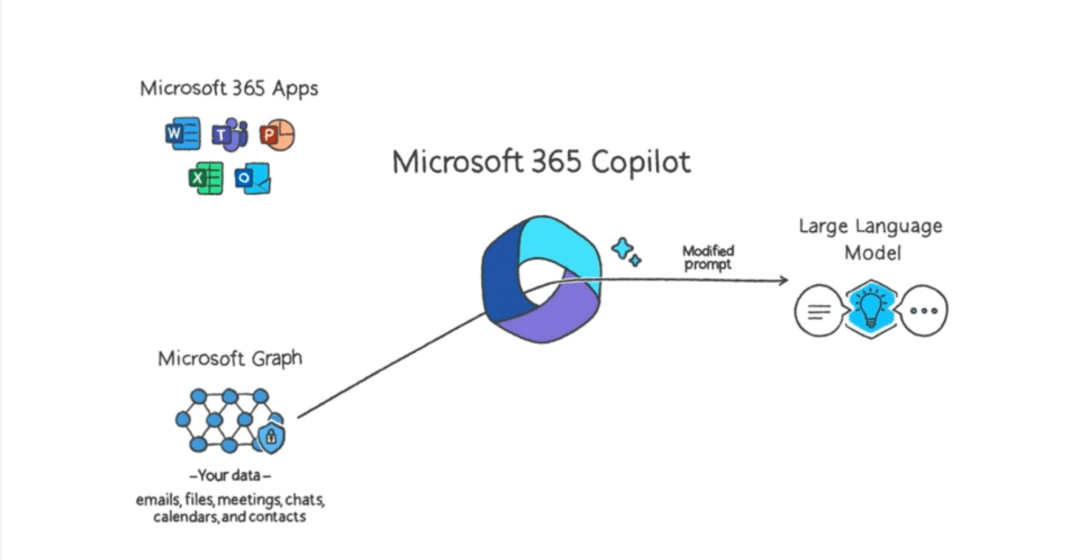

3.16日,微软发布会,震动发布了一堆Office的Copilot:Introducing Microsoft 365 Copilot — your copilot for work, [18]就为我们供给了上图的良多案例:

假设我们细看,那些Copilots仍是基于理解才能的根底,对与东西的挪用体例构成了差别水平、差别体例的连系。让GPT的理解才能融进到现有的工做流中,在人类需要算力、数据往“移砖”的时候,供给响应的搀扶帮助。

详细做到的体例,上图阐明的很清晰。假设笼统出来,其实就是让具备理解才能的LLM饰演一个法式员。如今的系统、数据、App,挪用体例都是为了让法式员来操做的。LLM有理解,有世界常识,给到关于你的常识,给原则化培训,就能饰演好一个有效法式员的角色,来挪用那些App,发扬本身的移砖才能。那里就有一个详细实现办法。[19]

才能看起来是震动听心的,但是也为我们带来了十分多的启发与鼓励。我相信OpenAI很快就会开放那些接口,而我们第一波时机就在把现有的东西和场景里,用GPT,按需设想出人类的copilot,替身类降本增效,脱节东西人命运。

a、短期:Better Prompting + 觅觅适宜的场景

记得两个重要推论:

1、ChatGPT是挪用算力和数据最合理手段;

2、ChatGPT在C端,是一个early-adopter的市场。群众承受尚需时日。

所以短期,把我们世界中现有的需求,与ChatGPT通过prompting的体例更好对接,调动更合适的算力与数据,会是重要的才能与打破。

在场景利用中,我们应该有两个原则:

1、 有的放矢:ChatGPT不是搜刮引擎、不是法式,我们就用它做它擅长的工作,而不是往做搜刮引擎和法式能够更高效完成的工作

2、 择善而从:当前的ChatGPT是有明显的hallucination问题的,那我们就不克不及100%相信它的结论。一个简单的办法是我们要在本身能揣度对错的处所往利用ChatGPT进步我们产生设法,搜集回纳信息的效率,但是人要来把关

上图来自于Introducing Microsoft 365 Copilot — your copilot for work,[20]阐明Microsoft 365 Copilot的做法。Microsoft有两个优势。第一个是有现成的消费力场景,第二个是有数据来提拔prompt的量量,生成更好的成果。

b、中期:ChatGPT Wrapper

Prompting其实是一个要求很高的综合才能。因为那要求一小我对“处理那个问题需要什么context”有理解,而大大都人只晓得本身在想什么,不晓得其别人需要晓得什么,也不晓得处理问题需要什么。所以关于大大都人来说,仍是需要把ChatGPT的才能包拆成详细处理计划,把context通过其他体例给到ChatGPT,然后让利用者做揣度题或者抉择题,而不是做开放答复题。

通过prompting,就很随便做到那一成果。通过诱导New Bing,已经看到了ChatGPT是若何跟搜刮停止连系的,就是通过一系列的天然语言来instruct它合理利用搜刮的才能。当ChatGPT开放更多prompting的长度,而且能让system prompting的attention可调,我们就能很便利地通过instruct prompting,把ChatGPT那一通用型铠甲适配到详细处理计划中。

c、持久:ChatGPT Native Solutions

ChatGPT Native Solution据我所知,是那里第一次在全网提到。那是一个很重要的概念,类似于智能机时代,Web Mobile和Mobile Native选型的认知。其时绝大大都开发者是看好web mobile的,Facebook在那里就走了一个大弯路。但是很快mobile native就展示了压服性的优势。我认为ChatGPT Native也会有类似优势。

再说清晰一点,其实ChatGPT native的意思就是把各类软件/法式/系统的输进输出接口,酿成天然语言。如许子就能够被以天然语言为接口的ChatGPT高效挪用和计算了。并且没有代码才能(但是有编程思维和工程思维)的人,也能够十分清晰天文解系统的肆意环节,停止有效发问和改进。

4.3 几个详细标的目的

a、LLM高考

ChatGPT到底能不克不及在某些场所替代人类工做?差别LLM产出的类似产物到底有没有乌鸦才能或者达成某些目标的才能?针对人类的测试其实不适用于AGI,而过往ML的才能权衡办法也不适用于AGI。

将来权衡AGI才能应该是主看和客看的连系。就像高考是人类智力和才能的不完美proxy一样,LLM也许很罕见到客看权衡,但正因如斯,做好权衡是很有意义的标的目的。

b、LLM培训

不但是prompt engineering那么简单。想让ChatGPT掌握一个范畴的深进常识,必然需要多轮对话,必然需要对话者一方面临教导学很懂,一方面临信息论很懂,一方面又是范畴专家。益处是教师教人类学生,杠杆很低,但是培训大模子,杠杆和回报很高,因为大模子教好了能代替千万万万个学生。

c、Personalized Private Search

为什么New Bing能那么快做出来?我们要明白两件事

1、New Bing没有(怎么)改动ChatGPT,而是通过instruct prompting(跟ChatGPT用天然语言规定一堆规则)的体例教给ChatGPT利用搜刮

2、搜刮原来就是人类语言查询信息而设想和办事的,而ChatGPT的输进输出又都是天然语言,所以适配十分简单天然。

但是我们的独有数据是不克不及被简单搜刮的。好比公司内部系统,我的小我聊天笔录,我上传的视频,等等。所以我们需要一个小我化、隐私化的,把本身数据contextual,index,之前方便搜刮的流程,之后才气让ChatGPT很好地利用。

那里要记得,GPT-3.5所以依靠的海量数据是为了提炼出阿谁理解才能用的,而不是为了增加它的常识用的。 ChatGPT挪用常识的更好手段是搜刮,而不是往往本身阿谁pre-trained大模子里添加常识。后者是过往ML的做法,别回往了。

人类和ChatGPT的素质区别是什么?

因为我们的脑科学和神经科学十分不兴旺,那里只能从哲学逃求解答。BTW,除非脑科学产生严重的范式打破,否则neurallink那种脑机接口,是不成能实现各人想像中的那些功用的。但我们不是哲学专家,那里就仅供参考。

5.1 揣度力

ChatGPT再凶猛,也只能往吸收虚拟数字中的数字信号,是无法与现实世界做实在交互的。它能够听一万个专家告诉他做A就会得到B,但是不从实在世界中做尝试,就无法从更底层确认那个说法事实是实是假。绝知此事要躬行,才气有揣度力的根底。

5.2 “Eureka”

牛顿看到苹果落地,能够发现万有引力,从而揣测星星的运动。哥白尼发现地球是围绕太阳转的,而在他之前全地球人天天看着日出日落,都认为太阳是绕着地球转的。假设阿谁时候有一个ChatGPT,必然十分笃定太阳绕着地球转。阿谁ChatGPT也许能从苹果若何落地揣度出桃子若何落地,但是可能率无法揣度出星星的运动体例。

5.3 增量常识

假设把现有常识回纳总结利用, 那一定PK不外ChatGPT。只要创造互联网上不存在的新常识,才可能是ChatGPT做不到的。重视前提指向,互联网上不存在的新常识,也未必不克不及从存量常识里总结出来,但是能从存量常识里总结出来的,必然不是人类的优势。

5.4 责备性思维

责备性思维是要主动往伪存实,不竭发现更重要的、更切近现实、更具创造力和价值的设法。ChatGPT似乎能找到一个好谜底,但是会不会不竭挑战那个谜底,找到更好的谜底呢?期看OpenAI暂且往研究和摸索它那一才能,否则确实很难揣测它能进化成什么样了。

5.5 理解人

人类的文本常识里必然存在良多人道的理解,但是也必然有一些人道或者偏好,是没有被笔录总结在文字里的。假设我们连系1和3,就会发现,往实在世界理解人,而不是往通过调研、问卷、收集材料理解人;往带来增量的理解,而不是往吠形吠声地反复套路。才是人类相关于ChatGPT的优势。

5.6 曲觉

回回ARLLM的素质。ARLLM是在试图生成下一个字没错,但是人类是不是也在做那件工作呢?欠好说。假设是生成下一句话,下一段呢?那那个时候,会不会(少少部门)人类的优势在于能一次生成一百段话之后的那句话?那可能就是所谓“曲觉”的digital定义了。不晓得模子能不克不及有那一天,但是应该会比力难。

5.7 烤面包

记得ChatGPT只存在于数字世界中,会进进意义世界以至感官世界,但是不会间接进进物理世界。在信息时代之前,人是不依靠于数字世界的。所以ChatGPT实的代替数字世界良多工做之后,人类也能够照旧保存。反而削减了良多东西属性,也许会活得更高兴。

总结

1、ChatGPT的范式打破是 “乌鸦”才能。恕才能所限,无法更简单地无损表达那一才能的素质了。假设容许有损,我会用 “理解”才能来归纳综合它最重要的一面。做为比照,过往ML的才能形式是 “鹦鹉”才能,所做的是觅觅 “对应关系”。

2、ChatGPT的意义是目前人类对“挪用算力和数据”的究极手段,揣测会在两年内有才能辅助人类,高效率完成大都可被定义为“移砖”的工做。

3、ChatGPT的“乌鸦”才能是涌现的,工程难度是极高的。我们应该放弃各类噪音,聚焦存眷Google能否能复现那一才能,从而断定那一才能到底有多灾。而如今,定见我们的默认揣测是那一才能很难复现,需要他人来用强力证据说服我们他们能复现。

4、我们对ChatGPT的利用应该看看OpenAI给我们供给的挪用体例,在当下,我们应该(1)用好ChatGPT,做好ChatGPT的项目司理;(2) 学会通过天然语言挪用ChatGPT;(3)觅觅做好ChatGPT才能与我们所需要处理问题的的中间层的时机。

本文仅代表做者小我看点,不代表腾讯研究院立场。

做者B站id:课代表立正

参考材料来源:

[1]

[3]

[5]

[6]

[7]/

[8]

[9]/

[10]

[11]

[12]

[13]

[14]

[15]

[16]

[17]

[18]/

[19]

[20]/

[21]

胡璇、胡晓萌:《ChatGPT之后,AIGC会若何改革内容创做?》

王强:《一文读懂:有关ChatGPT的十个问题》

👇 点个“在看”分享洞见