大佬在苹果MacBook上跑LLaMA,130亿参数大模子仅占8GB

智工具

做者 | 吴菲凝

编纂 | 李水青

智工具3月14日动静,据开发人员西蒙·威利森(Simon Willison)在本身的博客中称,他胜利在本身的条记本电脑上运行了Meta的130亿参数模子LLaMA-13B,那意味着大型语言模子已经能够跑在消费级硬件上了。

他还称,LLaMA-13B在大大都基准测试上的表示都优于拥有1750亿个参数的大型语言模子GPT-3,LLaMA-65B以至可与谷歌的Chinchilla-70B和PaLM-540B模子合作。

一、Mac能运行130亿参数大模子,只需8GB空间

一名软件开发人员乔治·格尔加诺夫(Georgi Gerganov)发布了一款名为“llama.cpp”的东西,该东西可助开发者在MacBook上运行AI大型语言模子LLaMA。

LLaMA全称为“Large Language Model Meta AI”,即Meta大型语言模子,其参数量从70亿到650亿不等,当参数越大时,模子所占用的空间就越多,运行时所消耗的算力也就越大。llama.cpp的次要目标就是在MacBook上利用4-bit量化运行大型语言模子。4-bit量化是一种减小模子大小的手艺,以便模子能够在功用较弱的硬件上运行,它还能削减磁盘上的模子大小:将LLaMA-7B削减到4GB、LLaMA-13B削减到8GB以下。

据AI开发者西蒙·威利森(Simon Willison)称,往年8月时发布的文本转图像模子Stable Diffusion开启了关于生成式AI的全新海潮,ChapGPT的呈现则将其推向了超速开展。现在,关于大型语言模子而言,类似于Stable Diffusion的时刻再次发作了。

他称本身第一次在本身的电脑上运行了类GPT-3语言模子。

展开全文

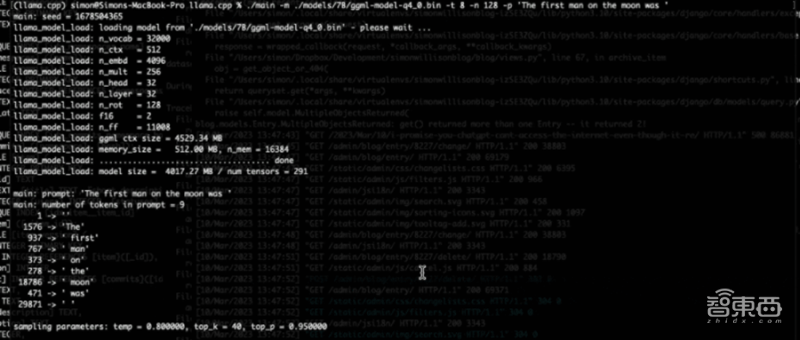

▲阿特姆·安德林科(Artem Andreenko)在4GB RAM的Raspberry Pi 4上运行LLaMA 7B

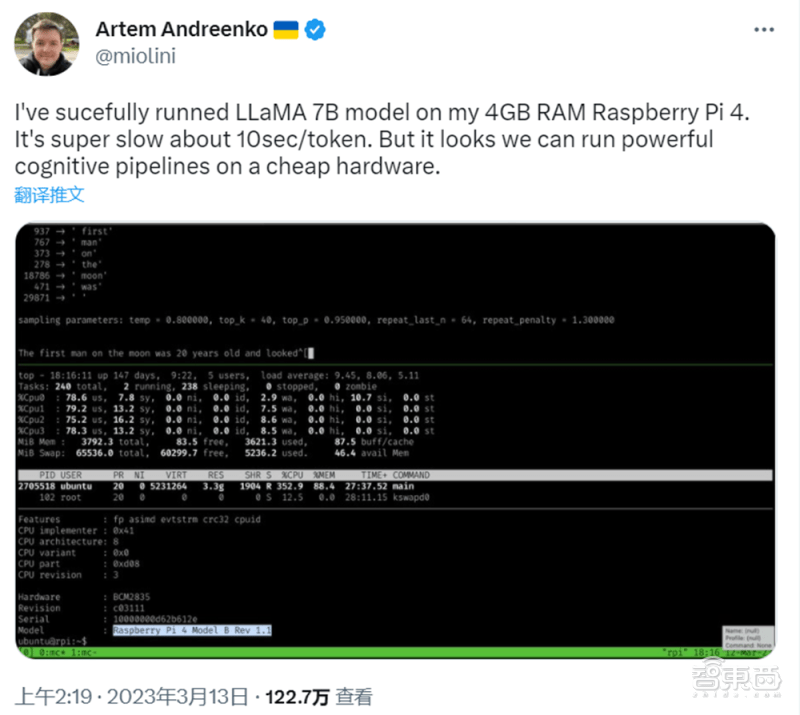

▲阿尼什·泰特(Anish Thite) 让它在 Pixel 6 手机上运行

威利森称,GPT-3如许的语言模子为ChatGPT等东西供给手艺支持,它比图像生成模子更大,构建和运行成本也更高。

大型语言模子中大部门都是由OpenAI等私家组织构建的,而且不断遭到严厉掌握——只能通过他们的API和Web界面拜候,不会发布给任何人在他们本身的电脑上运行。即便小我能够获得GPT-3模子,也无法在本身的硬件上运行,因为运行模子一般需要多个英伟达A100级GPU(Graphics Processing Unit,即图形处置器),单个售价超8000美圆。

而现在,威利森能够在本身的电脑上运行LLaMA-7B模子,并将它晋级到13B模子。他之前认为还需要几年时间才气在本身的硬件上运行GPT-3类模子,但现在已经能够做到了。语言模子的成本已经下降到小我电子设备也可用的地步。颠末4-bit量化之后,模子被缩小,LLaMA以至能够在装备M1芯片的MacBook上运行。

二、大型语言模子失往庇护屏障,须合理利用

与此同时,威利森认为在现实生活场景中,人们完全有可能操纵语言模子来做一些欠好的工作。好比编写垃圾邮件,造造感情圈套,以至还可能主动生成激进言论。

对生成式AI而言,编造一些虚假信息其实太随便了,而且人们也区分出来。在此之前,OpenAI还对人们与那些模子的交互行为停止有抉择的防备,但当通俗人都能在本身的消费级硬件上运行那些语言模子时,又该怎么办呢?

在威利森看来,假设不将大语言模子往积极的标的目的加以引导的话,人们很随便会在利用过程中陷进到它的陷阱中往,要么认为生成式AI有害,要么认为它浪费了本身的时间。

威利森称本身现在天天都在根据本身的目标来抉择利用生成式东西。他上周用ChapGPT来教本身进修Apple用以编写Mac系统的运行脚本。在ChapGPT的搀扶帮助下,他不到一小时就发布了一个新项目。

威利森认为当前人们的首要使命是找出最有建立性办法来利用ChatGPT。

结语:大型语言模子限造被突破,平替ChatGPT有看实现

虽然目前在MacBook上运行LLaMA的步调仍然繁琐复杂,但威尔森已在本身的博客中给出了详尽的步调阐明(”,人们通过消费级电子产物也能自若利用大模子。

来源:西蒙·威利森的博客