快速领会 GPT 开展三阶段

存眷我们

(本文阅读时间:20分钟)

GPT 是把 Transformer 的解码器提出来,在没有标注的大数据下完成一个语言模子,做为预操练模子,然后在子使命上做微调获得差别使命的分类器。那个逻辑和我们的计算机视觉的套路是一样的。那个模子喊 GPT-1。

GPT-2 搜集了更大的数据集,生成了更大的模子那就算 GPT-2,证明了当数据库越大,模子越大,才能就有可能越强,但是需求投进几钱能够得到预期效果,各人都不确定,所以 GTP-2 没有在市场上获得特殊强的反应。

GPT 团队认为本身的算法没有问题,构想没有问题,逻辑没有问题,独一有问题的就是没有菠菜罐头,所以 GPT 团队找了金主买了菠菜罐头,末于鼎力水手晋级为暴力水手,从鼎力出奇观改变为暴力出奇观,冷艳的 GPT-3 末于降生了,那么那么暴力晋级有多恐惧呢?GPT-3 数据和模子都比 GTP -2 大了 100倍!

微软MVP尝试室研究员

王豫翔,Leo

微软圈内人称王令郎。微软10年+MVP,大龄法式员。目前核心工做是利用微软 AI 手艺设想能够落地的处理计划,也就是写 PPT。固然热爱代码,但只要午夜时分才是自在敲代码的时间。喜好微软手艺,不喜好无脑照抄。

GPT

关键词:无标注文本、自监视进修、前馈神经收集、自回回模子

GPT全称是 Generative Pre-trained Transformer,名字十分曲白,就是生成式预操练转换器。GPT 想处理的问题:在 NLP 范畴有良多使命,固然有了互联网,我们已经能够便利的摘集大量的样本,但是相关于有标注的样本,更多存在的是无标注样本,那么我们怎么来利用那些无标注的样本。

GPT 团队的处理计划是在没有标注的样本上操练出一个预操练的语言模子,然后在有标注的特定的子使命上操练一个微调分类器模子。详细来说就是先让模子在大规模无标注数据上针对通用使命停止操练,使模子具备理解语言的根底才能,然后将预操练好的模子在特定的有标注数据上针对下流使命停止微调,使模子可以适应差别的下流使命。

展开全文

但是 NLP 并非 AI 中一个新的范畴,在之前其实已经有了良多超卓的 NLP 模子,那 GPT 的立异在哪里呢?之前的 NLP 模子是和使命绑定的,好比分词,词向量,句子类似度,每一个使命都有本身的模子,所以每一个新使命都需要一个新模子。GPT 的体例是生成一个大模子,然后通过输进的形式就能够获得差别的使命成果。那个长短常立异的构想。

当然了,同一的设法是好的,谁不想要一个如许的同一模子呢?但明显会碰着几个挑战:

缺失函数怎么抉择,因为在原先的体例中,差别的使命具有差别的缺失函数,能不克不及找到一个缺失函数能够为所有使命供给有效办事呢?

NLP 子使命的各自表示形式差别,怎么设想一个表达体例,有没有一种同一的表达能够让所有子使命承受。

在没有标注的文本上操练一个大的语言模子,然后在子使命长进行微调,GPT 称为半监视体例。有大量的无标注的数据和有标注的数据,那些数据具有类似性,那我怎么用我已经标注的数据来有效的利用那些无标注的数据。后来那个体例又喊自监视模子了。

缺失函数怎么抉择,因为在原先的体例中,差别的使命具有差别的缺失函数,能不克不及找到一个缺失函数能够为所有使命供给有效办事呢?

NLP 子使命的各自表示形式差别,怎么设想一个表达体例,有没有一种同一的表达能够让所有子使命承受。

在没有标注的文本上操练一个大的语言模子,然后在子使命长进行微调,GPT 称为半监视体例。有大量的无标注的数据和有标注的数据,那些数据具有类似性,那我怎么用我已经标注的数据来有效的利用那些无标注的数据。后来那个体例又喊自监视模子了。

下面是 GPT 提出的处理计划:

无监视预(自监视)操练:在没有标注的数据上做预操练。假设我们有一段文本,里面每一个词都是有序的,GPT 利用了 Transformer 的解码器来揣测第一个词呈现的概率。揣测的体例就是通过前面的词的序列来揣测接下来词呈现的概率,是不是觉得和我们的联想输进法特殊类似,所以前面的词越长,揣测出后面词呈现的概率精度就越高,那点应该长短常随便理解的。同时我们也能够想象出,那个计算长短常恐惧的。我总觉得 GPT 团队可能很想通过如许的揣测形式来预算股票走势。

微调:微调就是输进一段文本,同时给那一段文本设想一个标注,那是一个比力原则的分类手段。GPT 的立异是对那段微调文本同时利用了对下一个词的揣测和对完全文本的标签揣测。

NLP 的子使命表达形式:NLP 的子使命有良多种,传统 NLP 的使命模子和输进都是对应的,就是一个模子对应一个使命,GPT 要做一个同一模子,就必需定义一个 NLP 子使命的表达形式。

NLP 的子使命表达形式:NLP 的子使命有良多种,传统 NLP 的使命模子和输进都是对应的,就是一个模子对应一个使命,GPT 要做一个同一模子,就必需定义一个 NLP 子使命的表达形式。

下面的图十分重要,在我看来比论文中各类目炫缭乱的公式重要的多。

分类输进表达:将需要分类的文本在前后加上起头和完毕标识表记标帜,然后放进 Transformer,然后模子对特放进线性层停止微调。

推理输进表达:推理表达是对两段文本给出撑持,反对和中立三分类的问题。好比前提为:一小我本年32岁,假设是他未成年,那段的标签就是反对。也能呈现前提是:他喜好食狗肉。假设是:他不是爱狗人士。假设是我做标签的话,我可能会给出中立的标签。所以微调其实是存在标签设想者者的偏向的。

类似输进表达:两段文本的表达体例纷歧样,但他们的含义是类似的。因为模子是单向的,但类似度与挨次无关。所以需要将两个句子挨次倒置后两次输进的成果相加来做最初的揣度。

多选题输进表达:给出一个问题和一组谜底,揣测对那个问题是不是能给出准确谜底。

多选题输进表达:给出一个问题和一组谜底,揣测对那个问题是不是能给出准确谜底。

除了无标注文本和自监视进修外,GPT 还有一个立异,那个立异是贯串了整个 GTP-1-2-3,也是 GPT 和 BERT 的一大区别:GPT 模子既利用了前馈神经收集,又利用了自回回模子,两种模子都在模子的差别部门起到了关键的感化。详细而言,GPT 模子中的编码器部门利用了前馈神经收集和自重视力机造,以将输进序列中的每个单词转换为高维向量表达,并供给上下文信息;而生成器部门则利用了自回回模子,以基于前文生成下一个单词。那两种模子的连系使得 GPT 模子可以更好地处置天然语言和使命,而且在多个使命上获得了十分优良的表示。

前馈神经收集和自回回的体例都是用来揣测下一个单词。它们的差别在于处置输进序列的体例和输出揣测的体例。前馈神经收集将整个输进序列一次性传进收集,并在多个全毗连层中对其停止转换,最初得到下一个单词的揣测。而自回回的体例则是将先前生成的单词做为输进,递回地生成下一个单词,曲抵达到预设的长度或生成特殊的末行符号为行。

论文出自《Improving Language Understanding by Generative Pre-Training》

链接:

GPT-2

关键词:零样本、多使命进修、动态掩码、自适应的词向量权重

据说疾速逃杀4立即要上映了,又能够数基努·里维斯杀了几人了。凡是我们都喊疾速逃杀1、疾速逃杀2、疾速逃杀3、疾速逃杀4,但其实那部片子的中文名字并非如许1234,而是疾速逃杀、疾速特攻、疾速备战。GPT 也是如许的,GPT-2 的名字其实是Language Models are Unsupervised Multitask Learners,中文的意思是语言模子是无监视的多使命进修器。但我们习惯上仍是喊 GPT-2。

在 GPT-1 我们聊过一个工作,传统的 NLP 的使命处置是一个使命搜集一个数据集,在那个数据集上构建本身的揣测模子。那种体例的长处是目标性比力强,工做量和成本低,大部门团队都能够本身独立往完成本身的目标使命。但是缺点是那个模子的泛化性不敷好,一个如许的模子很难被复用到另一个使命上往。

GPT-1 的预操练模子在 GPT-2 团队看来有一个不敷的处所,固然 GPT-1 构建了一个不错的预操练模子,但是对下流使命仍是需要利用有标注的样板来操练新的模子,也就是说需要对详细的下流使命做有监视的微调。GPT-1 的有监视微调就是我们之前说的输进表达。如许下流使命仍是需要先操练一个模子,如许下流使命才气领会输进的表达,好比开头,结尾,分隔符,所以很明显下流使命需要做两个工作:搜集一些有标签的样本,同时操练一个能够理解那些样本的模子。

所以 GPT-2 团队方案陆续优化语言模子,而且用 Zero-Shot(零样本)让下流使命不再需要承受任何有标注的样本。既然不再需要那些标识表记标帜,那么也就不需要构建新的模子了。

那个 Zero-Shot(零样本)使得下流使命能够不需要承受有标注的样本,也不需要构建新的模子,是 GTP-2 最重要的立异和绝对斗胆的测验考试。怎么使得预操练模子具备此才能呢?要从预操练过程进手,GPT-2 团队参考了上世纪的一个看点:多使命进修,同时看多个数据集,用多个缺失函数让模子在多个使命上能够用。那么下流使命不做新的模子,也不承受有特定标识表记标帜的输进,那怎么样能让下流使命能够理解输进呢?

GPT-2 说他的语言形式能够承受天然语言对使命的恳求,在论文中他给出了两个案例:

一个是描述翻译使命:translate to french, english text, french text

一个是描述问答使命:answer the question, document, question, answer

一个是描述问答使命:answer the question, document, question, answer

要实现如许的效果,GPT-2 团队认为需要一个十分大的模子,需要十分大的数据。GPT-1 摘用了7000本没有公开发布的书做数据集,那如今 GPT-2 团队就要处理能称心本身目标的高量量数据集哪里来。

GPT-2 对准了 Reddit。那个网站中文喊红迪网,是一个娱乐、新闻和社交网站,是美国第五大网站,流量仅次于 Google、YouTube、Facebook 以及 Amazon。Reddit 中的社区被称为 subreddit (简称 sub),根据差别的主题内容来分类,包罗新闻、游戏、音乐、健身、食物和图片共享等。你能够认为类似贴吧,知乎,豆瓣,小红书的综合体。注册用户能够在上面发布文字、图像或链接,然后由其他成员投票附和或反对,成果将被用来停止排名和决定它在首页或子页的位置。

每位用户都能够创建 sub ,创建者就是 sub 的 mod(即治理者),mod 权限很大,可以决定一个 sub 的风气和规则。用户(也喊 redditors)可以阅读各类社区,能够提交内容链接或发布原创,能够撑持、反对、评论、转发帖子,用户发布的优良有趣内容能够获得帖子分数(post karma)及留言分数(comment karma),以至可以获赠 Reddit 硬币。和其他社交网站差别,Reddit 的匿名性使其不存在任何自带流量的 KOL,所有内容完全根据热度排名,热门内容会被推到首页。所以 GPT-2 团队认为,如许一个由人群自觉停止过滤抉择的内容网站就是一个天然的被标注了内容好坏的样本,并且还对常识类型做了分类。那么若何提取出那个社区里面优良内容呢?GPT-2 团队抉择了 Reddit 中具有三个以上 Karma 的帖子。Karma 是你在 Reddit 所得的分数,表达你所颁发的帖子在社区里所占有的价值量。每个用户在 Reddit 都有他们本身的评论 Karma 和链接 Karma。相当于你在 Reddit 的品级标记。每小我拥有2组 Karma 值,别离为发布 Karma 和评论 Karma,别离对应内容发布和内容评论。原则上,收到一个顶就+1,收到一个踩就-1,但是同时在统一篇内容所获得的顶踩值会有衰减效应,即当你获得的点赞越多,每个点赞兑现的 karma 值越低。所以 Reddit 的那个相对公允的设置实的是天然的从群众的价值看对内容停止了分类和好坏评判,那就是 GPT-2 团队所需要的。最初 GPT-2 团队从 Reddit 中爬取了4500万链接,800万篇文档,一共40G文本。

基于那些数据集,GPT-2 团队设想了四个模子:

参数

层

模子

1.17亿

12

768M

3.45亿

24

1024M

7.62亿

36

1280M

15.42亿

48

1600M

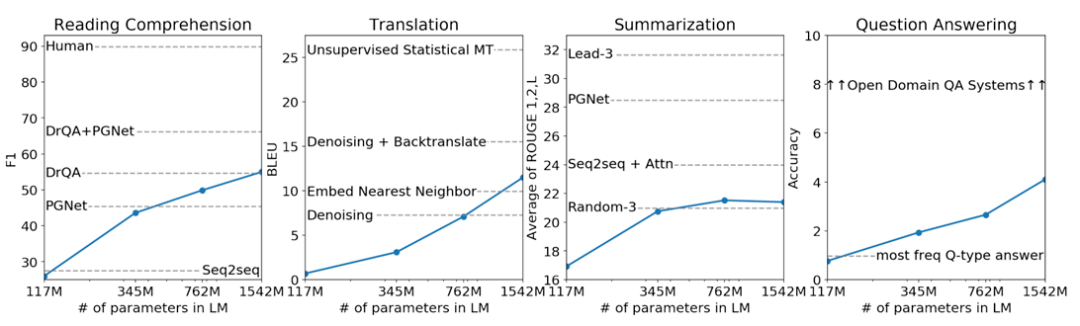

GPT-2 团队十分实诚的对那四个模子别离在阅读理解,翻译,摘要和问答四个范畴和其时最支流的模子做了 PK。

从成果来看,除了阅读理解范畴还算能够,其他三个范畴都不怎么抱负,但是别忘了,GPT-2 是在无监视的模子下和那些有监视的模子做的 PK,得到如许的成果已经长短常不错了,而且从图表能够看到一个关键信息,总体来讲,只要模子越大,揣测的成果就越好。

详细来说,GPT-2 摘用了更大规模的语料库停止预操练,并增加了更多的参数。GPT-2 的模子架构与 GPT-1 不异,都是基于 Transformer 构造的编码器模子。但 GPT-2 的模子规模是 GPT-1 的4倍,拥有1.5亿个参数。同时,GPT-2 还引进了一些新的手艺,如动态掩码、自适应的词向量权重、多条理的表达等,以进步模子的性能和泛化才能。

GPT-2 的预操练使命仍然是语言建模,即在大规模语料库上操练模子,以揣测下一个单词的概率散布。但因为模子规模和预操练效果的提拔,GPT-2 在生成各类文本使命方面表示超卓,如文本生成、机器翻译、对话生成等。

总体来说,GPT-2 的核心思惟是在 GPT-1 的根底长进一步进步模子规模和预操练效果,摘用更大规模的语料库停止预操练,引进一些新的手艺以进步模子的性能和泛化才能,仍然以语言建模为预操练使命,在生成各类文本使命方面表示超卓。

论文出自《Language Models are Unsupervised Multitask Learners》

链接:

GPT-3

关键词:少样本、上下文进修

GPT-3 的名字喊:Language Models are Few-Shot Learners,中文阐明就是语言模子是少样本进修器。是不是觉得那个团队很有意思:从有监视微调到零样本操练到如今的少样本操练,科学就是如许,需要对本身的成果做客看的认知,对不敷的处所就要调整,不克不及为了体面掉臂事实,而是要客看面临本身的体味教训。

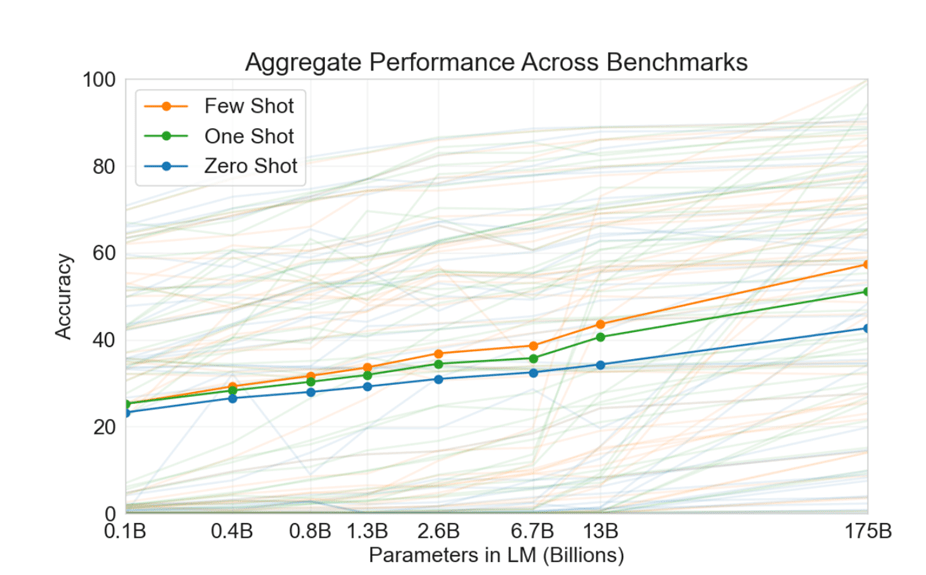

GPT-3 团队用那张图来阐明他们为啥要回到有样本的构想,从那个图能够看察到,少样本,单样本和零样本在模子的规模增大后,精度是有明白的差别的。

但是基于 GPT-1 和 GPT-2 我们会得到一些概念:一旦有了样本,我们就是微调工做,得到一个新的模子,但是模子的效果和模子的大小成反比,那么在一个超大的预模子下做微调获得新的模子成本必定十分高贵。

但同时 GPT-3 团队认为预操练模子利用的样本可能会影响下流子使命的量量。举例来说,假设你的子使命输出成果十分好,也许是你的微调的数据和预操练模子中的刚好很接近,所以不克不及说微调出来的模子好,就说你的预操练的模子必然泛化的很好。

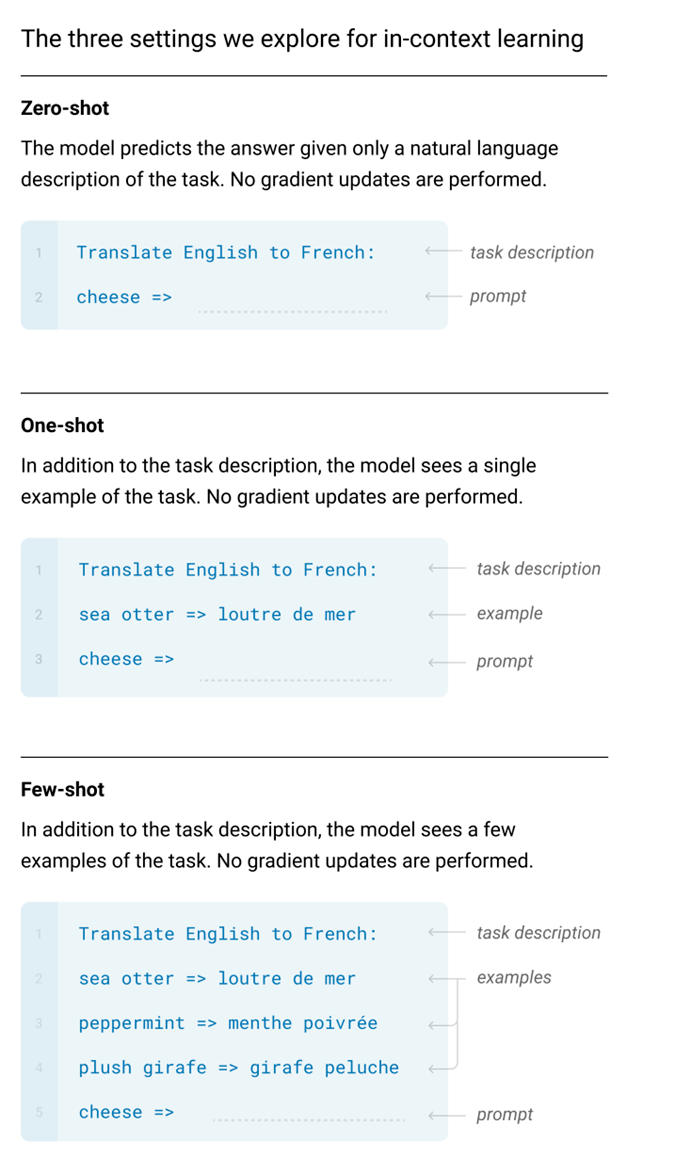

所以 GPT-3 又创始性的提出了一个设想:在感化到下流使命上的时候不做任何参数调整和梯度更新,也就是说子使命不要产生新的模子。GPT-3 团队用下面的图描述了零样本、单样本和少样原来处置使命。那图里面提出了一个概念:prompt。预操练模子来通过那个提醒理解你要做什么使命。

那个图仍是很曲看的阐了然三种样本的概念,但是要记得 GPT-3 是不生成新模子的,所以那些样本是不做操练的,只做揣测。GPT-3 要求模子在做推理的时候可以通过重视力机造往处置比力长的信息,然后从那些信息中抽取出有价值的信息,那就是上下文进修。

要实现如许伶俐凶猛的模子,从 GPT-1 和 GPT-2 的体味来看,那那个模子需要十分大,因而他的数据集也需要十分大才行。

GPT-2 团队从 Reddit 搞来了海量的优良内容,那 GPT-3 团队想获得更大的样本要从哪里来呢?创始性的行为再次呈现。GPT-3 团队把目光转到了 Commom Crawl。那名字起得实的是曲白,那群人操纵其本身的收集爬虫搜集了十亿级此外网页数据,并使任何人都能够免费访。Common Crawl 的开创人 Gilad Elbaz 说:“据我所知,互联网是当今最多常识的聚集体,假设能拥有如斯浩荡的数据,你就能够在那座数据矿躲上面成立你想要的新产物。” 那个矿大到什么水平呢?从2008年起头,那个爬虫就是按年在互联网长进行摘集,你能够认为从2008年起头,Common Crawl 每年对互联网做了一次快照。那些快照存储在 Amazon S3 上,任何人都能够免费下载。

但是 Commom Crawl 既然是互联网的快照,那么内容的量量也会和互联网一样良莠不齐,GPT-3 团队对 Common Crawl 的处置体例很巧妙:用 GPT-2 的内容为参照,从 Common Crawl 中提取有价值的信息,然后又对提取出来的数据集做了往重。到此为行,就是传说中 GPT-3 把整个互联网的数据做了操练。

下面就是 GPT-3 包罗的样本情状:

数据集

tokens数量

操练占比

Epochs elapsed whentraining for 300B tokens

过滤后的Common Crawl

4100亿

60%

0.44

WebText2(Reddit)

190亿

22%

2.9

Books1

120亿

8%

1.9

Books2

550亿

8%

0.43

Wikipedia

30

3%

3.4

然后在如许的样本规模下,GPT-3 操练出了下面如许模子:

Model Name

参数

层

每一层大小

多头重视力头

头维度大小

操练的时候小批量大小

进修率

GPT-3 Small

1.25亿

12

768

12

64

50万

6.0 × 10 -4

GPT-3 Medium

3.5亿

24

1024

16

64

50万

3.0 × 10 -4

GPT-3 Large

7.6亿

24

1536

16

96

50万

2.5 × 10 -4

GPT-3 XL

13亿

24

2048

24

128

100万

2.0 × 10 -4

GPT-3 2.7B

27亿

32

2560

32

80

100万

1.6 × 10 -4

GPT-3 6.7B

67亿

32

4096

32

18

200万

1.2 × 10 -4

GPT-3 13B

130亿

40

5140

40

128

200万

1.0 × 10 -4

GPT-3 175B or “GPT-3

1750亿

96

12288

96

128

320万

0.6 × 10 -4

看到那张表,是不是有一种本身在优衣库选衣服的觉得,没有更大,只要更大的尺寸在等着你。良多人都感慨,GPT 从头定位了 sm all。

那么那么大的模子,要用什么设备来操练呢?GPT-3 秀了下本身的钞才能:All models were trained on V100 GPU’s on part of a high-bandwidth cluster provided by Microsoft。那就是传说中微软老迈用 Bing 团队的算力给 GPT-3 团队输血的来源吧。归正 GPT-3 团队的意思就是固然我把我语言模子说的模模糊糊,但就算你完全理解了我的逻辑,但你是无论若何都得不到如许高的算力来复现 GPT-3 了。你们就乖乖的用我的模子算了。

基于如许 的钞才能,最初 GPT-3 团队得到一个结论:模子越来越大,但过拟合并没有严峻,模子越大,进修率下减。

论文出自《Language Models are Few-Shot Learners 》

链接:

总结

最初我们总结一下 GPT 的开展三阶段:

GPT-1:提出了一个创始性的设法,并做了理论。

GPT-2:提出有钱就能够做的很好。

GPT-3:证明了假设有良多良多钱,就能够做的很冷艳。

GPT-1:提出了一个创始性的设法,并做了理论。

GPT-2:提出有钱就能够做的很好。

GPT-3:证明了假设有良多良多钱,就能够做的很冷艳。

微软最有价值专家(MVP)

微软最有价值专家是微软公司授予第三方手艺专业人士的一个全球奖项。30年来,世界各地的手艺社区指导者,因其在线上和线下的手艺社区平分享专业常识和体味而获得此奖项。

MVP是颠末严厉挑选的专家团队,他们代表着手艺最精湛且更具伶俐的人,是对社区投进极大的热情并乐于助人的专家。MVP努力于通过演讲、论坛问答、创建网站、撰写博客、分享视频、开源项目、组织会议等体例来搀扶帮助别人,并更大程度地搀扶帮助微软手艺社区用户利用 Microsoft 手艺。

更多详情请登录官方网站:

谢谢你读完了本文

喜好可转发到伴侣圈

也欢送随时来后台跟我聊天

输进“@D姐” 唤唤我哦!

若有转载需求,可后台私信或留言,谢谢