GAN强势回来?英伟达消耗64个A100操练StyleGAN-T,优于扩散模子

选自arXiv

做者:AXel Sauer

机器之心编译

编纂:赵阳

扩散模子在文本到图像生成方面是更好的吗?不见得,英伟达等机构推出的新款 StyleGAN-T,成果表白 GAN 仍具有合作力。

文本合成图像使命是指,基于文本内容生成图像内容。当下那项使命获得的浩荡停顿得益于两项重要的打破:其一,利用大的预操练语言模子做为文本的编码器,让利用通用语言理解实现生成模子成为可能。其二,利用由数亿的图像 - 文本对构成的大规模操练数据,只要你想到的,模子都能够合成。

操练数据集的大小和笼盖范畴继续飞速扩展。因而,文本生成图像使命的模子必需扩展成为大容量模子,以适应操练数据的增加。比来在大规模文本到图像生成方面,扩散模子(DM)和自回回模子(ARM)催生出了浩荡的停顿,那些模子似乎内置了处置大规模数据的属性,同时还能处置高度多模态数据的才能。

有趣的是,2014 年,由 Goodfellow 等人提出的生成匹敌收集(GAN),在生成使命中并没有大放异彩,合理各人认为 GAN 在生成方面已经不可的时候,来自英伟达等机构的研究者却试图表白 GAN 仍然具有合作力,提出 StyleGAN-T 模子。

论文地址:

论文主页:/

StyleGAN-T 只需 0.1 秒即可生成 512×512 辨认率图像:

展开全文

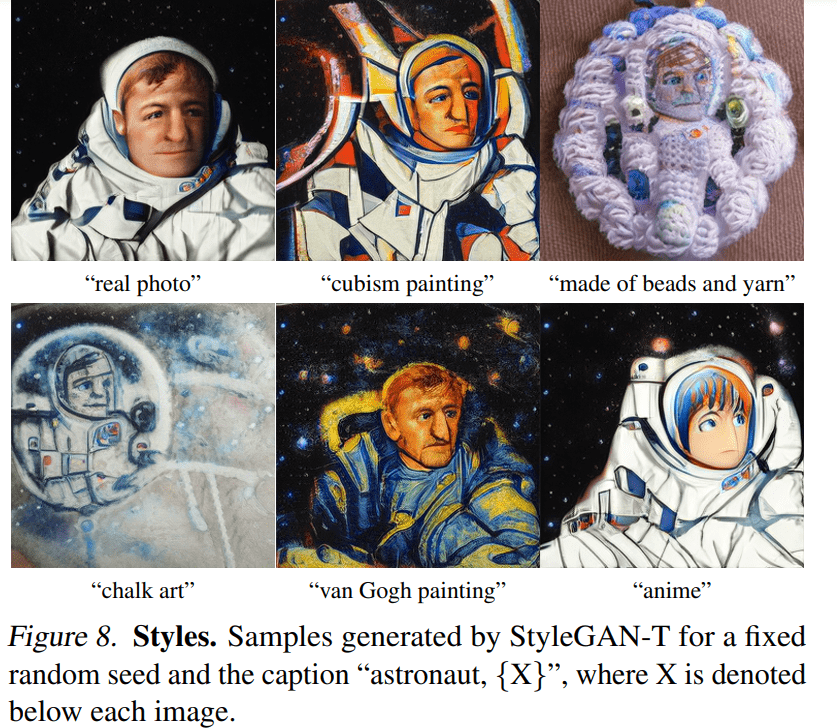

StyleGAN-T 生成宇航员图像:

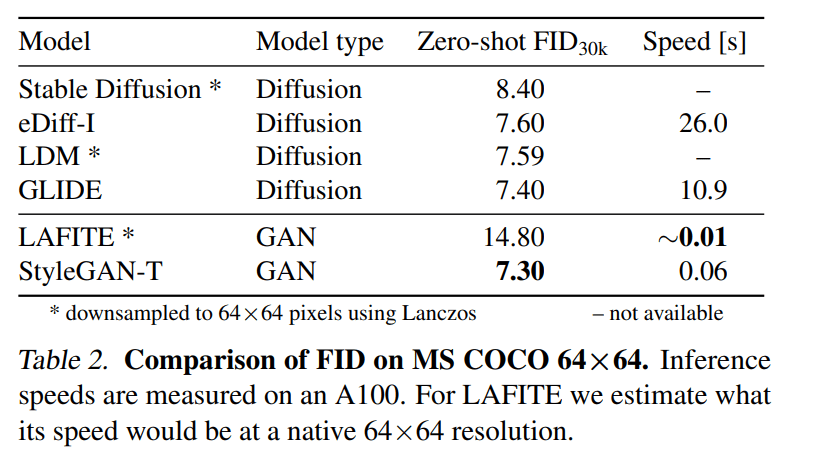

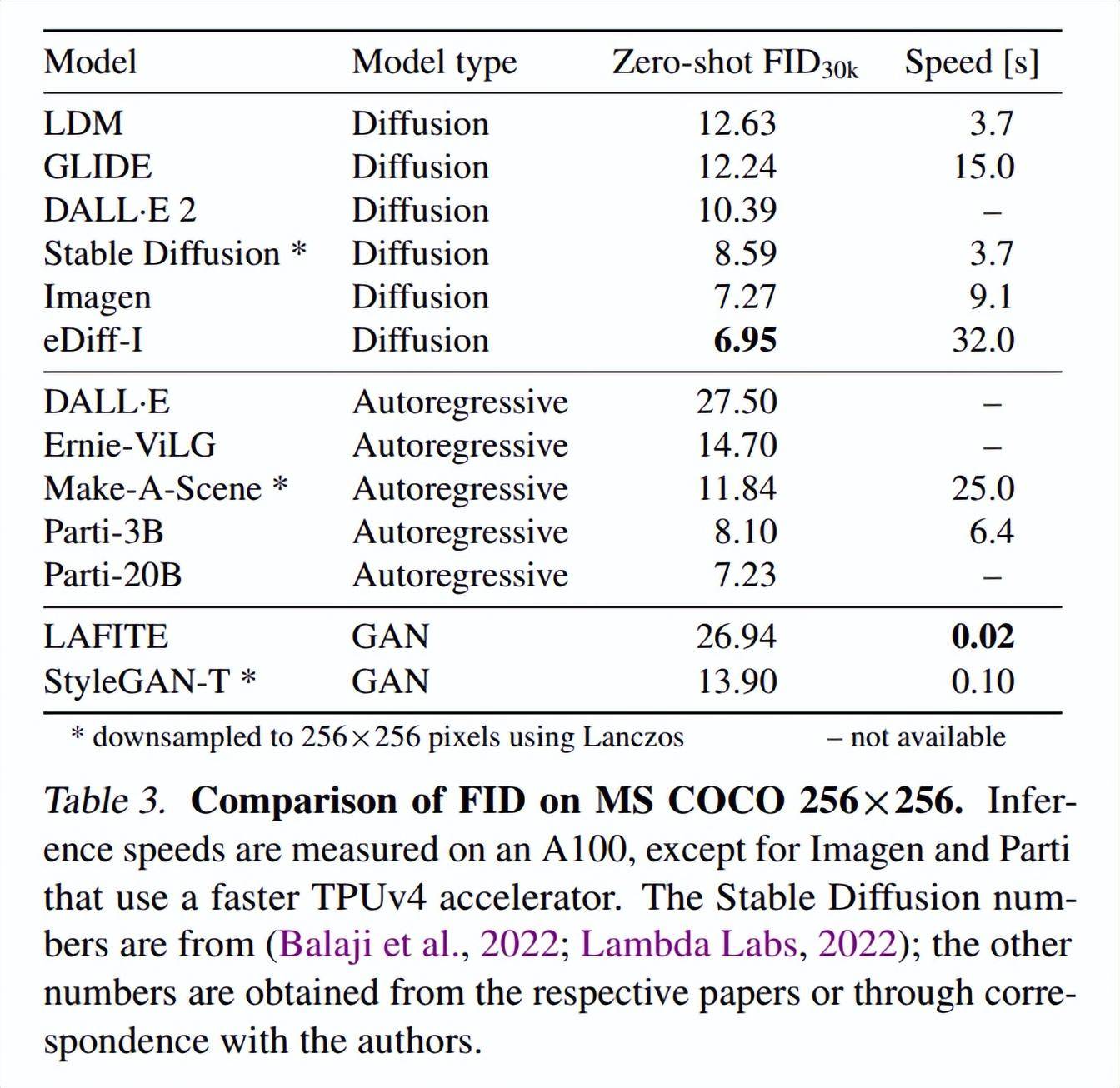

值得一提的是,谷歌大脑研究科学家 Ben Poole 表达:StyleGAN-T 在低辨认率 (64x64) 时生成的样本比扩散模子更快更好,但在高辨认率 (256x256) 时表示欠安。

研究者们表达,他们在 64 台 NVIDIA A100 长进行了 4 周的操练。有人给那项研究算了一笔账,表达:StyleGAN-T 在 64 块 A100 GPU 上操练 28 天,根据订价约为 473000 美圆,那大约是典型扩散模子成本的四分之一……

GAN 供给的次要益处在于推理速度以及能够通过隐空间掌握合成的成果。StyleGAN 的特殊之处在于,其具有一个精心设想的隐空间,能从底子上把控生成的图像成果。而关于扩散模子来说,虽然有些工做在其加速方面获得了显著停顿,但速度仍然远远落后于仅需要一次前向传布的 GAN。

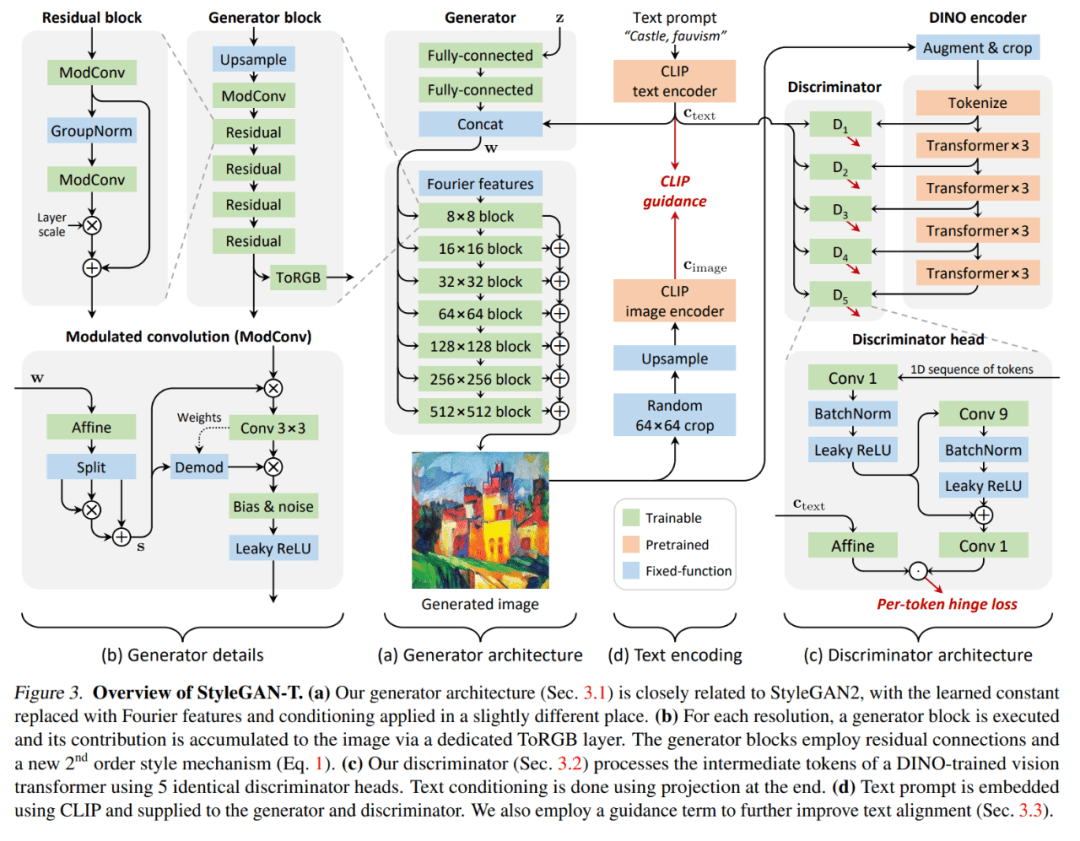

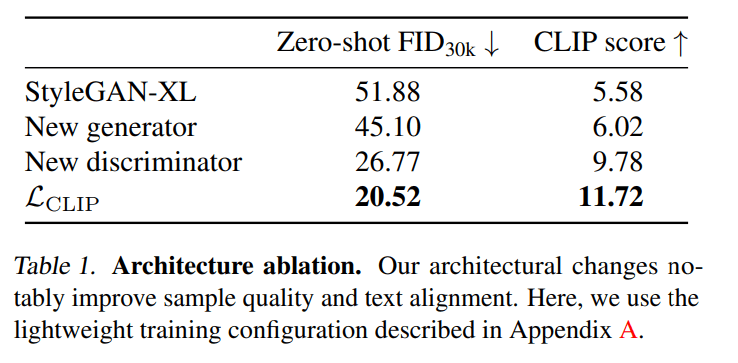

本文从看察到 GAN 在 ImageNet 合成中同样落后于扩散模子中得到启发,接着受益于 StyleGAN-XL 对判别器的架构停止了重构,使得 GAN 和扩散模子的差距逐步缩小。在原文的第 3 节中,考虑到大规模文本生成图像使命的特定要求:数量多、类别多的数据集、强大的文本对齐以及需要在改变与文本对齐间停止权衡,研究者以 StyleGAN-XL 做为起头,从头审阅了生成器和判别器的架构。

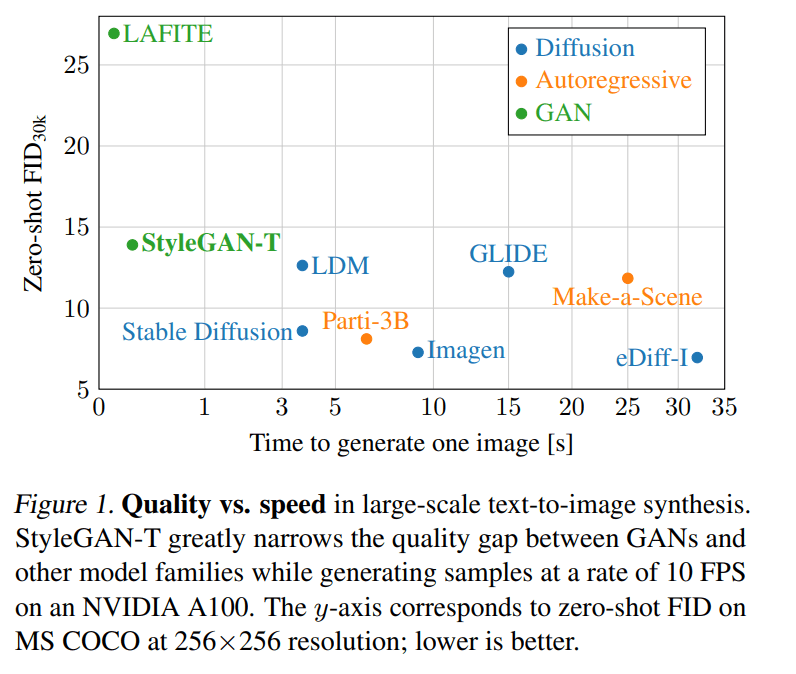

在 MS COCO 上的零样本使命中,StyleGAN-T 以 64×64 的辨认率实现了比当前 SOTA 扩散模子更高的 FID 分数。在 256×256 辨认率下,StyleGAN-T 更是到达之前由 GAN 实现的零样本 FID 分数的一半,不外仍是落后于 SOTA 的扩散模子。StyleGAN-T 的次要长处包罗其快速的推理速度和在文本合成图像使命的上下文中停止隐空间光滑插值,别离如图 1 和图 2 所示。

StyleGAN-T 架构概览

该研究抉择 StyleGAN-XL 做为基线架构,因为 StyleGAN-XL 在以类别为前提的 ImageNet 合成使命中表示超卓。然后该研究依次从生成器、判别器和变长与文本对齐的权衡机造的角度修改 StyleGAN-XL。

在整个从头设想过程中,做者利用零样本 MS COCO 来权衡改动的效果。出于现实原因,与原文第 4 节中的大规模尝试比拟,测试步调的计算资本预算有限,该研究利用了更小模子和更小的数据集;详见原文附录 A。除此以外,该研究利用 FID 分数来量化样素质量,并利用 CLIP 评分来量化文本对齐量量。

为了在基线模子中将以类别为引导前提更改为以文本为引导前提,做者利用预操练的 CLIP ViT-L/14 文本编码器来嵌进文本提醒,以此来取代类别嵌进。接着,做者删除了用于引导生成的分类器。那种简单的引导机造与早期的文本到图像模子相婚配。如表 1 所示,该基线办法在轻量级操练设置装备摆设中到达了 51.88 的零样本 FID 和 5.58 的 CLIP 分数。值得重视的是,做者利用差别的 CLIP 模子来调剂生成器和计算 CLIP 分数,那降低了报酬强调成果的风险。

尝试成果

该研究利用零样本 MS COCO 在表 2 中的 64×64 像素输出辨认率和表 3 中的 256×256 像素输出辨认率下定量比力 StyleGAN-T 的性能与 SOTA 办法的性能。

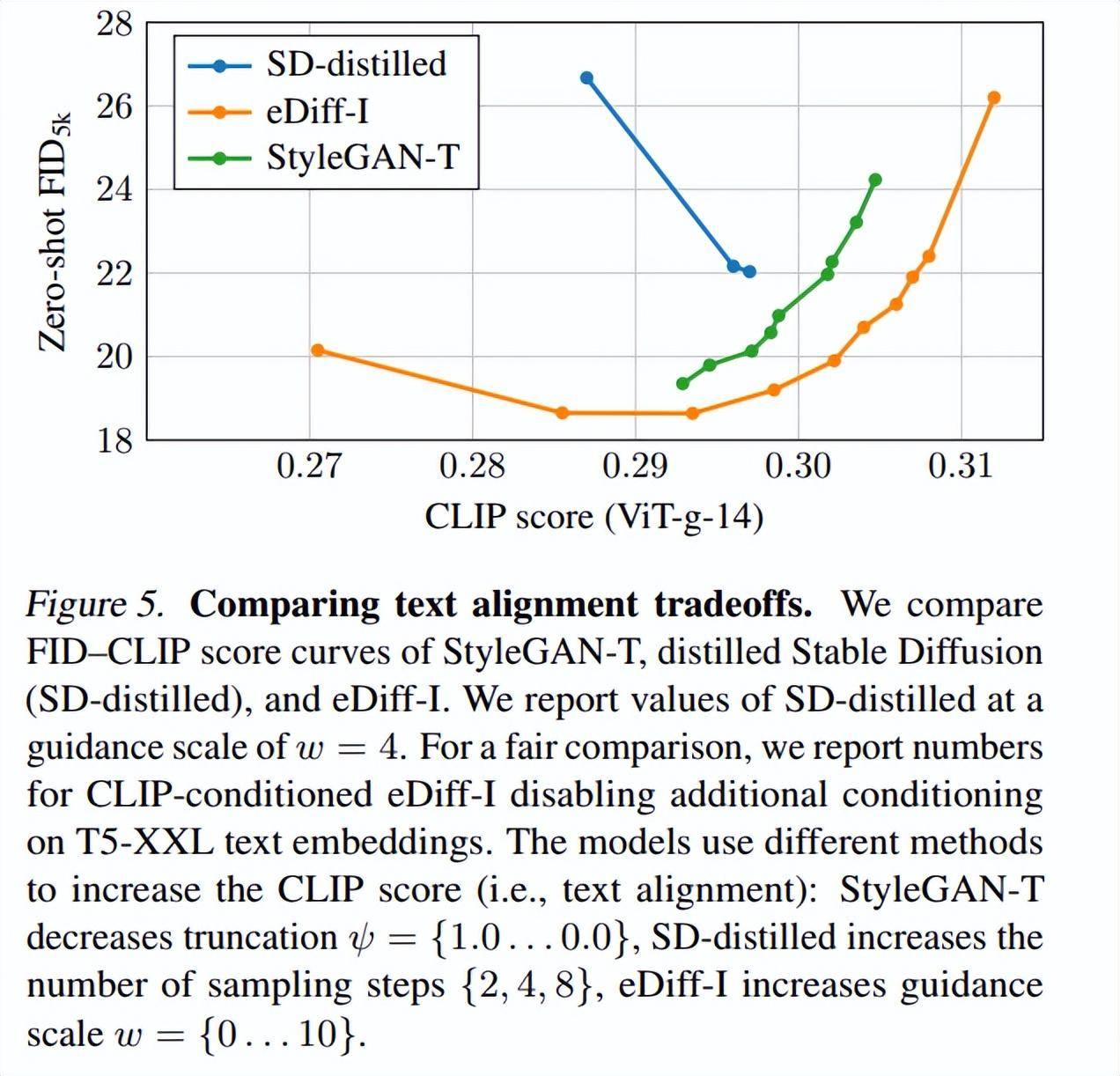

图 5 展现了 FID-CLIP 评分曲线:

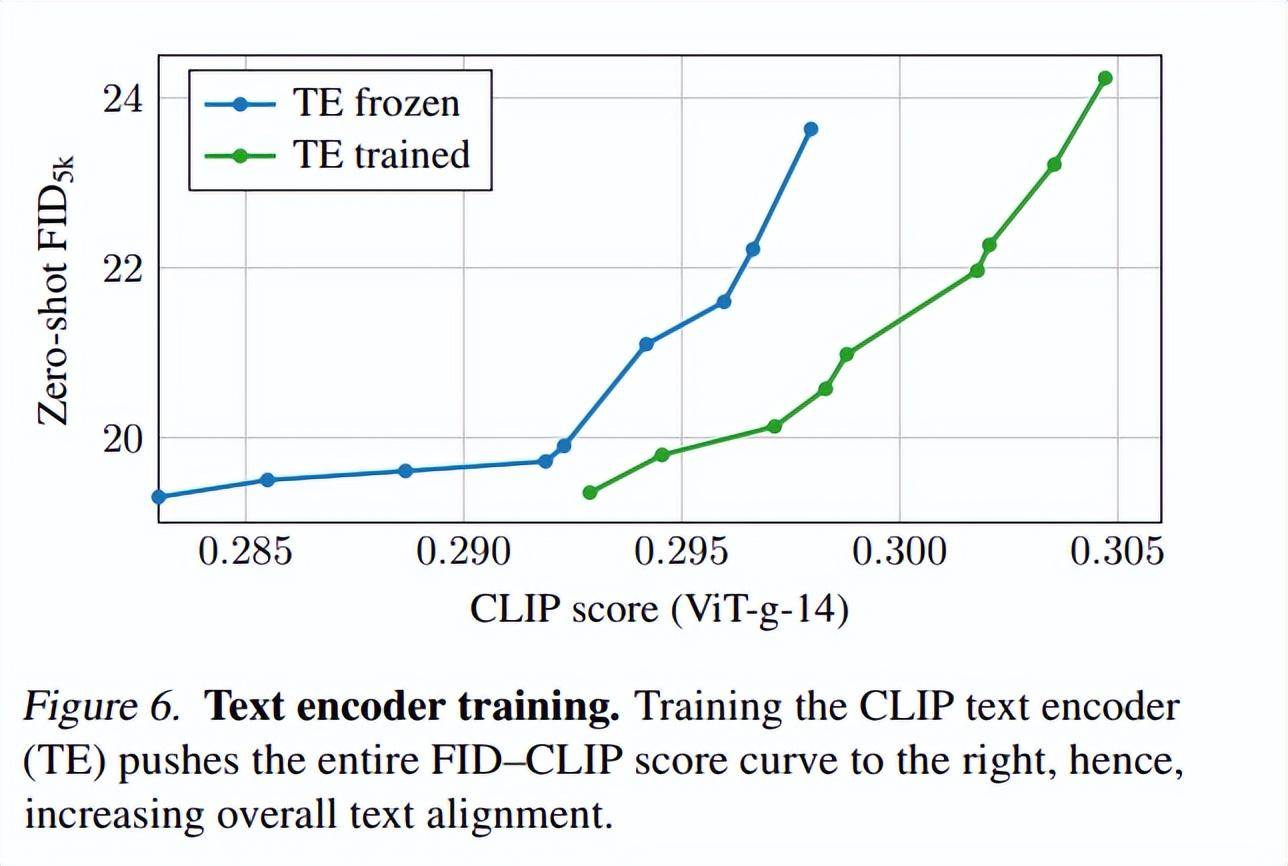

为了隔离文本编码器操练过程产生的影响,该研究评估了图 6 中的 FID–CLIP 得分曲线。

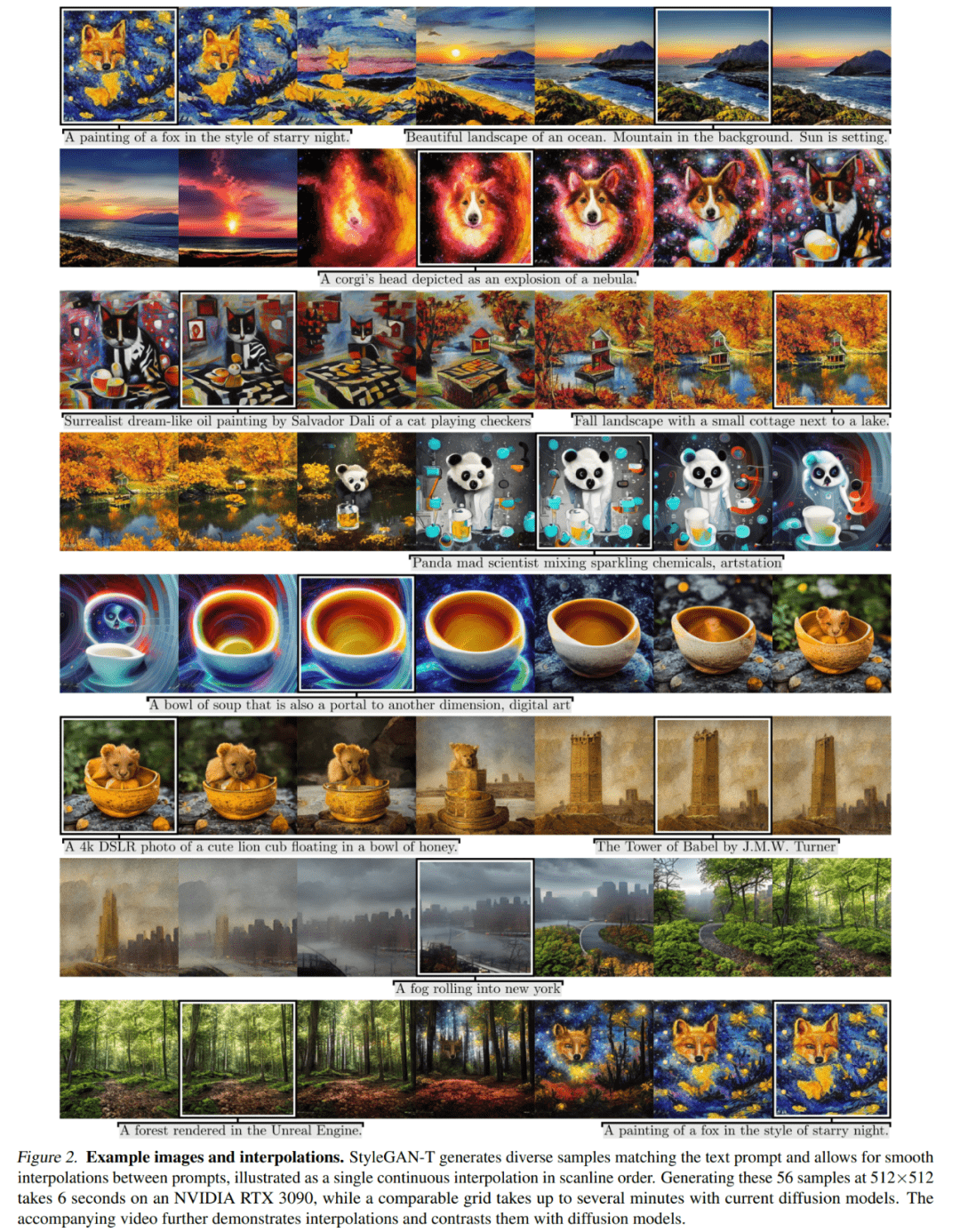

图 2 展现了 StyleGAN-T 生成的示例图像,以及它们之间的插值。

在差别的文本提醒之间停止插值十分简单。关于由中间变量 w_0 = [f (z), c_text0] 生成的图像,该研究用新的文本前提 c_text1 替代文本前提 c_text0。然后将 w_0 插进到新的隐变量 w_1 = [f (z), c_text1] 中,如图 7 所示。

通过向文本提醒附加差别的款式,StyleGAN-T 能够生成多种款式,如图 8 所示。