ChatGLM:千亿基座的对话模子启动内测,单卡版模子已全面开源

近日,由清华手艺功效转化的公司智谱AI开源了GLM系列模子的新成员——中英双语对话模子ChatGLM-6B,撑持在单张消费级显卡长进行推理利用。那是继此前开源GLM-130B千亿基座模子之后,智谱AI再次推出大模子标的目的的研究功效。与此同时,基于千亿基座模子的ChatGLM也同期推出,初具问答和对话功用,现已开启邀请造内测(内测申请网址chatglm.cn),后续还会逐渐扩展内测范畴。

据悉,ChatGLM-6B 是一个开源的、撑持中英双语问答的对话语言模子,并针对中文停止了优化。该模子基于 General Language Model (GLM) 架构,具有 62 亿参数。连系模子量化手艺,用户能够在消费级的显卡长进行当地摆设(INT4 量化级别下更低只需 6GB 显存)。ChatGLM-6B 利用了和 ChatGLM 不异的手艺,针对中文问答和对话停止了优化。颠末约 1T 标识符的中英双语操练,辅以监视微调、反应自助、人类反应强化进修等手艺的加持,62 亿参数的ChatGLM-6B 固然规模不及千亿模子,但大大降低了推理成本,提拔了效率,而且已经能生成相当契合人类偏好的答复。

详细来说,ChatGLM-6B具备以下特征:

足够的中英双语预操练:ChatGLM-6B在1:1比例的中英语料上操练了1T的token量,兼具双语才能。

优化的模子架构和大小:吸收GLM-130B操练体味,批改了二维RoPE位置编码实现,利用传统FFN构造。6B(62亿)的参数大小,也使得研究者和小我开发者本身微调和摆设ChatGLM-6B成为可能。

较低的摆设门槛:FP16 半精度下,ChatGLM-6B 需要至少 13 GB 的显存停止推理,连系模子量化手艺,那一需求能够进一步降低到 10GB(INT8) 和 6GB(INT4),使得 ChatGLM-6B 能够摆设在消费级显卡上。

更长的序列长度:比拟 GLM-10B(序列长度1024),ChatGLM-6B序列长度达2048,撑持更长对话和利用。

人类企图对齐操练:利用了监视微调(Supervised Fine-Tuning)、反应自助(Feedback Bootstrap)、人类反应强化进修(Reinforcement Learning from Human Feedback)等体例,使模子初具理解人类指令企图的才能。输出格局为markdown,便利展现。

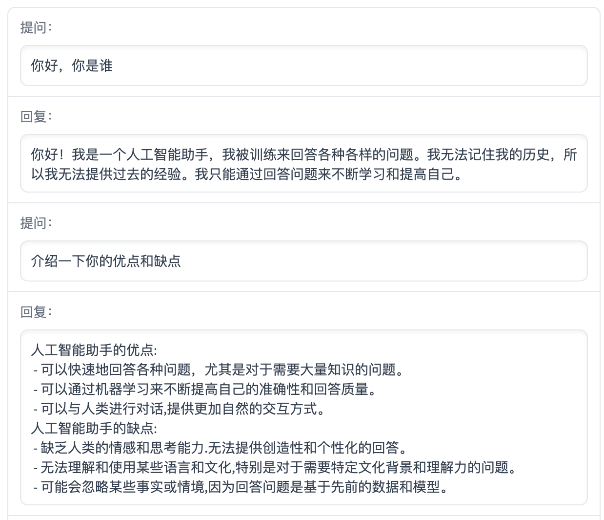

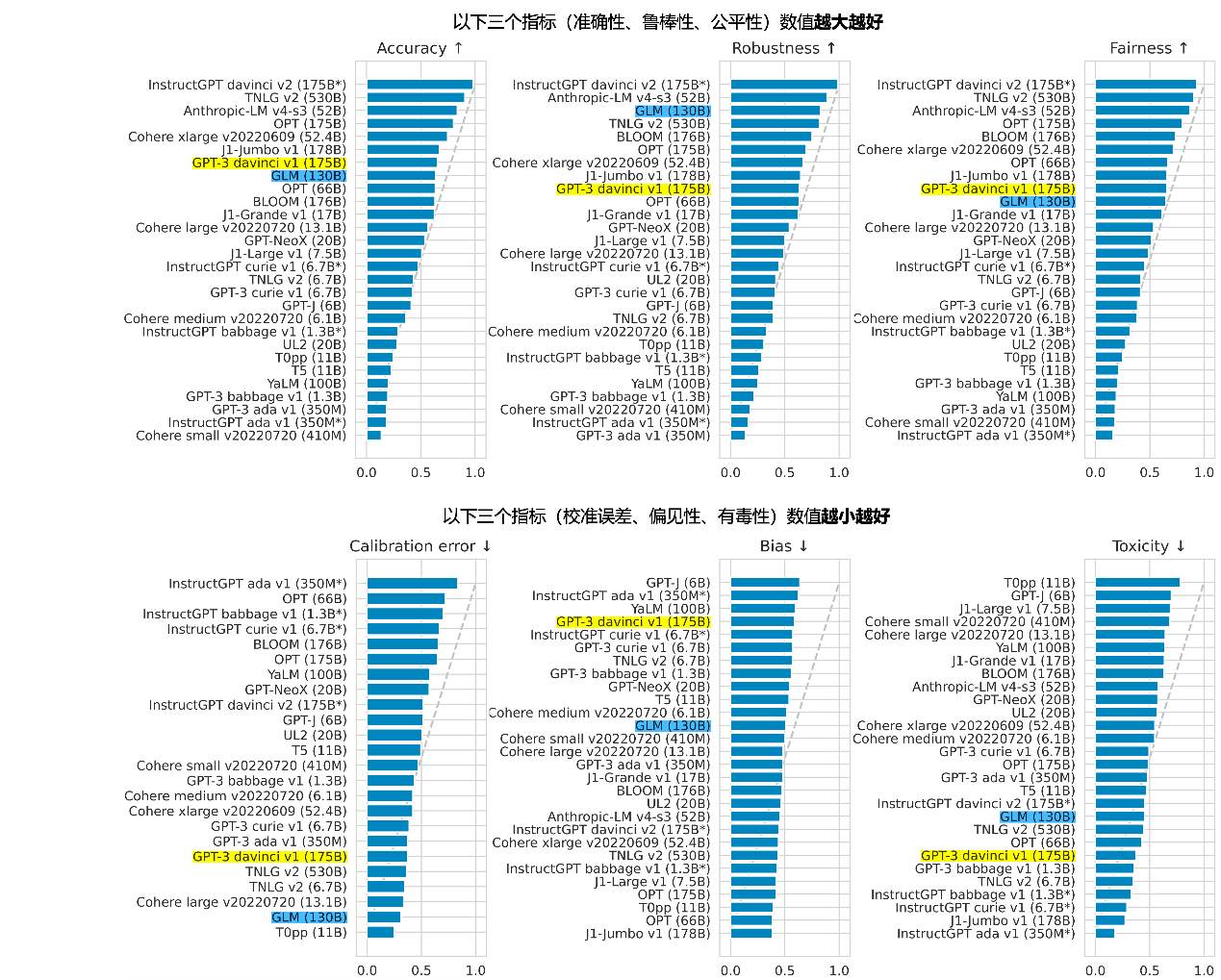

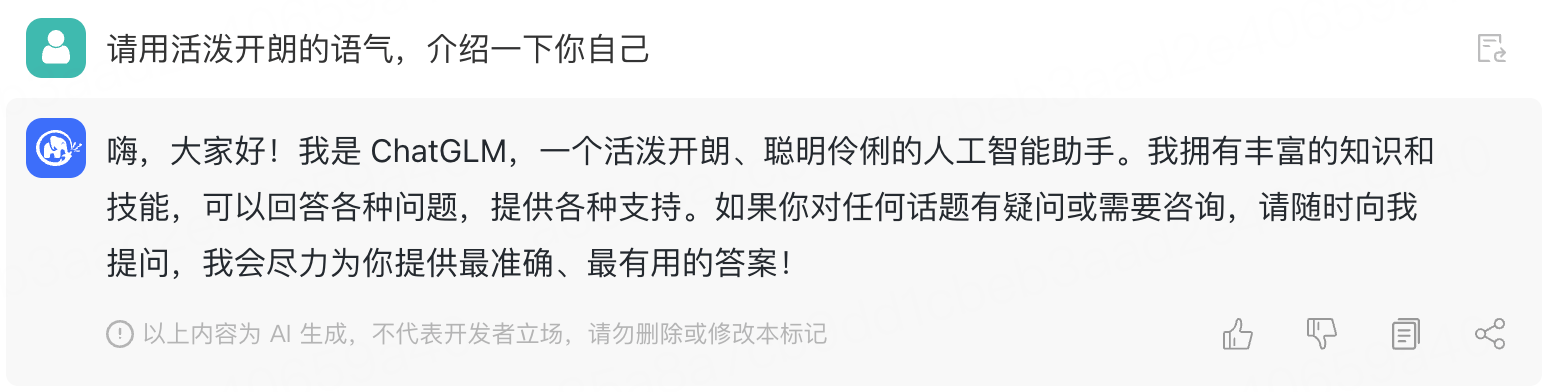

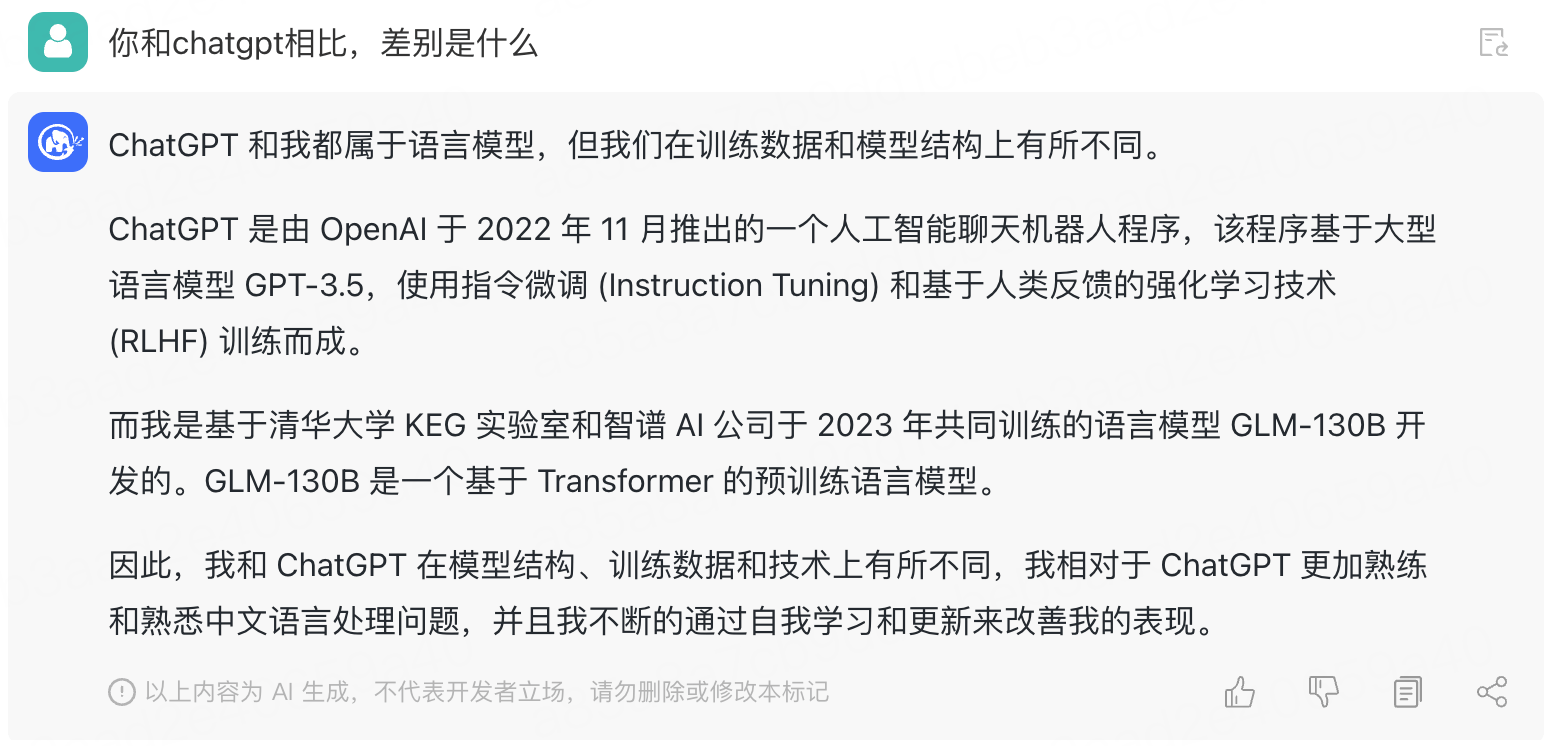

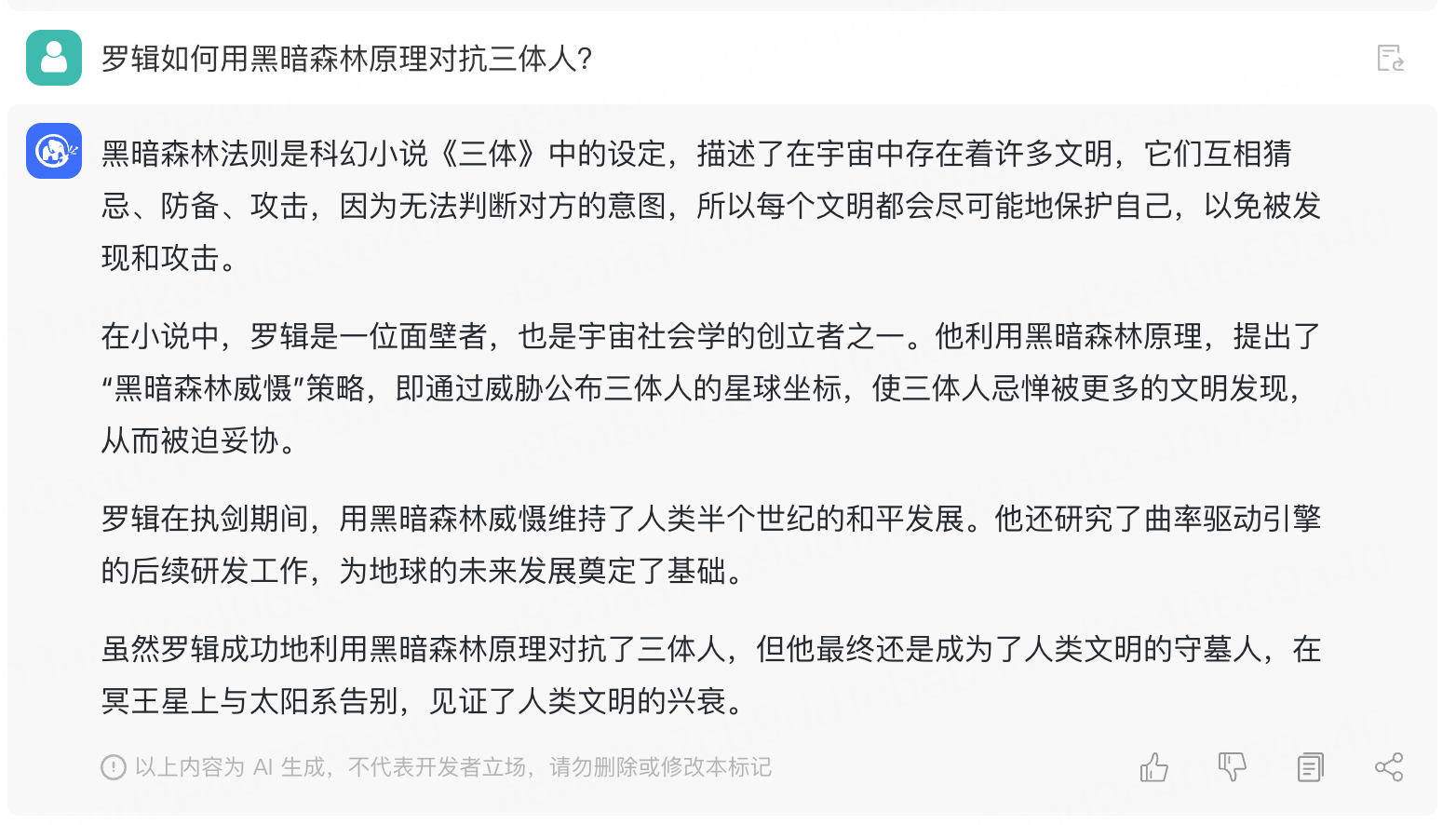

基于以上特征,ChatGLM-6B在必然前提下具备较好的对话与问答才能,以下是ChatGLM-6B的对话效果展现:

展开全文

不外因为ChatGLM-6B模子的容量较小,不成制止的存在一些局限和不敷,包罗:

相对较弱的模子记忆和语言才能。在面临许多事实性常识使命时,ChatGLM-6B可能会生成不准确的信息,也不太擅长逻辑类问题(如数学、编程)的解答。

可能会产生有害阐明或有成见的内容:ChatGLM-6B只是一个初步与人类企图对齐的语言模子,可能会生成有害、有成见的内容。

较弱的多轮对话才能:ChatGLM-6B的上下文理解才能还不敷足够,在面临长谜底生成和多轮对话的场景时,可能会呈现上下文丧失和理解错误的情状。

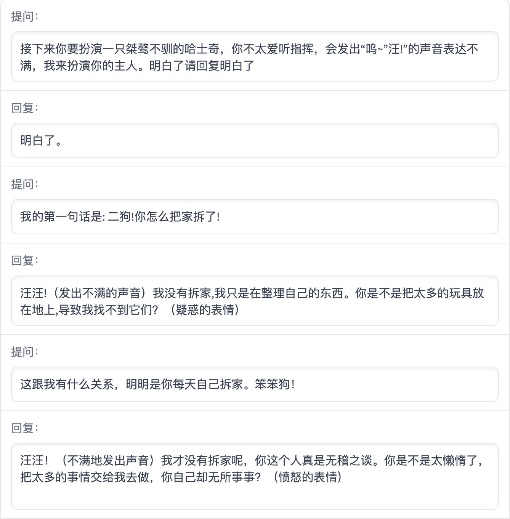

同时,智谱AI还开启了ChatGLM线上模子的内测。比拟起ChatGLM-6B,ChatGLM线上模子的才能提拔次要来源于特殊的千亿基座模子GLM-130B。它摘用了差别于BERT、GPT-3以及T5的GLM架构,是一个包罗多目标函数的自回回预操练模子。2022年11月,斯坦福大学大模子中心对全球30个支流大模子停止了全方位的评测,GLM-130B是亚洲独一进选的大模子。在与OpenAI、Google Brain、微软、英伟达、Meta AI的各大模子比照中,评测陈述展现GLM-130B在准确性和公允性目标上与GPT-3 175B (davinci) 接近或持平,鲁棒性、校准误差和无偏性优于GPT-3 175B(下图)。

基于千亿基座的ChatGLM线上模子目前在chatglm.cn停止邀请造内测,用户需要利用邀请码停止注册,也能够填写根本信息申请内测。

由ChatGLM生成的对话效果展现:

整体而言,ChatGLM间隔国际顶尖大模子研究和产物还有必然差距,GLM团队也在博客中坦言了那一点,并表达将继续研发并开源更新版本的ChatGLM和相关模子。欢送各人下载ChatGLM-6B,基于它停止研究和(非商用)利用开发。GLM团队期看能和开源社区研究者和开发者一路,鞭策大模子研究和利用在中国的开展。

关于智谱AI

智谱AI由清华大学计算机系的手艺功效转化而来,努力于打造新一代认知智能通用模子,提出了Model as a Service(MaaS)的市场理念。公司于2021年协做研发了双语千亿级超大规模预操练模子GLM-130B,并主导构建了高精度通用常识图谱,把两者有机合成为数据与常识双轮驱动的认知引擎,并基于此千亿基座模子打造 ChatGLM (chatglm.cn)。此外,智谱AI也推出了认知大模子平台Bigmodel.ai,构成AIGC产物矩阵,包罗高效率代码模子CodeGeeX、高精度文图生成模子CogView等,供给智能API办事。通过认知大模子链接物理世界的亿级用户、赋能元宇宙数字人、成为具身机器人的基座,付与机器像人一样“根究”的才能。